Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Haotian | CryptoInsight

Chercheur indépendant | Conseiller @ambergroup_io | Chercheur spécial @IOSGVC | Science pure et dure | Précédemment :@peckshield | DMs pour Collab| Community est uniquement ouvert aux abonnés Substack

Parlons de l'événement très médiatisé de l'enchère de la stablecoin $USDH de @HyperliquidX.

À première vue, il semble s'agir d'une bataille d'intérêts entre plusieurs émetteurs comme Frax, Sky, Native Market, mais en réalité, c'est une "enchère publique" pour le droit de frappe de la monnaie stable, qui va changer les règles du jeu sur le marché des stablecoins.

Je vais partager quelques points de vue en me basant sur les réflexions de @0xMert_ :

1) La lutte pour le droit de frappe de l'USDH révèle un conflit fondamental entre la demande d'applications décentralisées pour des stablecoins natifs et la nécessité d'une liquidité unifiée pour les stablecoins.

En termes simples, chaque protocole majeur essaie d'avoir son propre "droit d'imprimer de l'argent", mais cela va inévitablement fragmenter la liquidité.

Pour résoudre ce problème, Mert a proposé deux solutions :

1. "Aligner" les stablecoins de l'écosystème, où tout le monde s'accorde à utiliser un stablecoin commun et à partager les bénéfices proportionnellement. La question se pose : si USDC ou USDT est le stablecoin aligné le plus consensuel, seraient-ils prêts à partager une grande partie de leurs bénéfices avec les DApps ?

2. Construire une couche de liquidité pour les stablecoins (modèle M0), en utilisant une pensée Crypto Native pour créer une couche de liquidité unifiée, par exemple en utilisant Ethereum comme couche d'interopérabilité, permettant aux différents stablecoins natifs d'échanger sans couture. Cependant, qui va supporter les coûts d'exploitation de cette couche de liquidité, qui va garantir l'ancrage des différentes architectures de stablecoins, et comment résoudre les risques systémiques causés par le désancrage de certains stablecoins ?

Ces deux solutions semblent raisonnables, mais elles ne peuvent résoudre que le problème de la fragmentation de la liquidité, car une fois que l'on prend en compte les intérêts de chaque émetteur, la logique devient incohérente.

Circle, qui gagne des milliards de dollars chaque année grâce à un rendement de 5,5 % sur les obligations d'État, pourquoi devrait-elle partager avec un protocole comme Hyperliquid ? En d'autres termes, lorsque Hyperliquid sera en mesure de se séparer des émetteurs traditionnels de stablecoins, le modèle de "gagner sans effort" de Circle sera également remis en question.

L'événement d'enchère de l'USDH peut être considéré comme une démonstration contre l'"hégémonie" des émetteurs traditionnels de stablecoins ? À mon avis, que la révolte réussisse ou échoue n'est pas important, ce qui compte, c'est le moment où l'on se lève.

2) Pourquoi dis-je cela ? Parce que le droit aux bénéfices des stablecoins finira par revenir aux créateurs de valeur.

Le modèle traditionnel d'émission de stablecoins, où Circle et Tether font essentiellement du commerce d'intermédiaire, consiste à ce que les utilisateurs déposent des fonds, qu'ils utilisent pour acheter des obligations d'État ou les déposer sur Coinbase pour percevoir des intérêts fixes, mais la plupart des bénéfices leur reviennent.

Évidemment, l'événement USDH vise à leur faire comprendre que cette logique a un bug : c'est le protocole qui traite les transactions qui crée réellement de la valeur, et non pas simplement les émetteurs qui détiennent des actifs de réserve. Du point de vue d'Hyperliquid, traitant plus de 5 milliards de dollars de transactions par jour, pourquoi devrait-elle céder des revenus annuels de plus de 200 millions de dollars provenant des obligations d'État à Circle ?

Dans le passé, la "sécurité de la circulation des stablecoins sans désancrage" était la première demande, donc les émetteurs comme Circle, qui ont engagé d'importants "coûts de conformité", devraient bénéficier de cette part de revenus.

Mais avec la maturation du marché des stablecoins et l'éclaircissement progressif de l'environnement réglementaire, cette part de droits de bénéfice sera transférée aux créateurs de valeur.

Ainsi, à mon avis, la signification de l'enchère USDH réside dans le fait qu'elle définit une toute nouvelle règle de répartition des bénéfices des stablecoins : celui qui maîtrise la véritable demande de transaction et le flux d'utilisateurs a la priorité pour bénéficier de la répartition des bénéfices ;

3) Alors, quel sera le dénouement final ? Les chaînes d'applications domineront-elles le discours, tandis que les émetteurs deviendront des "fournisseurs de services en arrière-plan" ?

Mert a mentionné une troisième solution très intéressante, où les chaînes d'applications génèrent des revenus, tandis que les bénéfices des émetteurs traditionnels tendent vers zéro ? Comment comprendre cela ?

Imaginons qu'Hyperliquid génère des revenus de plusieurs centaines de millions de dollars uniquement grâce aux frais de transaction en un an, tandis que les revenus potentiels des obligations d'État gérées, bien que stables, deviennent "accessoires".

Cela explique pourquoi Hyperliquid ne choisit pas de diriger l'émission elle-même mais préfère céder le droit d'émission, car il n'y a pas besoin de le faire, émettre soi-même augmenterait "la dette de crédit", et les bénéfices obtenus ne sont pas aussi attrayants que d'augmenter le volume des transactions pour les frais.

En fait, regardez, lorsque Hyperliquid a cédé le droit d'émission, la réaction des enchérisseurs prouve tout cela : Frax a promis de reverser 100 % des bénéfices à Hyperliquid pour le rachat de HYPE ; Sky a proposé un rendement de 4,85 % avec un rachat annuel de 250 millions de dollars ; Native Markets a proposé un partage 50/50, etc. ;

Essentiellement, la bataille d'intérêts entre les DApps et les émetteurs de stablecoins s'est déjà transformée en un jeu de "compétition interne" entre les émetteurs, surtout que les nouveaux émetteurs poussent les anciens à changer les règles.

Voilà.

La quatrième solution de Mert, qui semble un peu abstraite, si elle se réalise, pourrait signifier que la valeur de marque des émetteurs de stablecoins pourrait complètement disparaître, ou que le droit d'émission pourrait être entièrement unifié sous le contrôle des régulateurs, ou qu'il pourrait s'agir d'un certain protocole décentralisé, cela reste encore incertain. Cela devrait encore appartenir à un avenir lointain.

En résumé, à mon avis, cette bataille chaotique pour l'enchère USDH peut annoncer la fin de l'ère de "gagner sans effort" des anciens émetteurs de stablecoins, et guider véritablement le droit aux bénéfices des stablecoins vers les "applications" qui créent de la valeur, ce qui est déjà d'une grande signification !

Quant à savoir s'il s'agit de "corruption électorale", si l'enchère est transparente, je pense plutôt que c'est une opportunité de fenêtre avant la mise en œuvre réelle de réglementations comme le GENIUS Act, il suffit de regarder le spectacle.

mert | helius.devil y a 22 heures

Prédiction : à la fin du jeu, vous ne verrez pas du tout le ticker sur les stablecoins.

Vous n'aurez pas de USDC ou de USDT ; vous n'aurez que du USD.

Hyperliquid et l'épreuve du USDH ont rendu un grand service à tout l'espace.

Si vous voyez tous ces émetteurs se battre entre eux jusqu'à zéro, pourquoi ne devraient-ils pas faire de même pour d'autres protocoles avec des utilisateurs ?

(Oui, je suis conscient que la plupart des grandes entreprises négocient une partie du rendement à leur retour en coulisses, mais même ces entreprises passent à côté d'un tas de revenus parce qu'elles n'ont pas de pouvoir de négociation collectif de cette manière)

Avec une réglementation appropriée en cours maintenant, il n'y a aucune raison pour que les applications qui font le travail d'attirer des utilisateurs en premier lieu soient écartées.

On pourrait soutenir qu'auparavant, c'était acceptable parce qu'il n'y avait vraiment pas beaucoup d'émetteurs de stablecoins de confiance, et vous n'auriez aucune idée de leur légitimité — ce n'est plus le cas maintenant.

Je soupçonne que c'est pourquoi ils commencent tous à faire des chaînes spécifiques aux paiements, car tout le monde sait que ces marges doivent se comprimer (et que des réductions de taux arrivent).

Tout le monde avec une distribution devrait exiger plus des émetteurs, et je m'attends à ce que beaucoup d'entre eux commencent à sortir leurs propres stablecoins.

Mais cela crée un nouveau problème : la fragmentation de la liquidité.

Il y a quelques façons de résoudre cela :

i) Un stablecoin "aligné" à l'écosystème qui fait un assez bon travail pour la plupart des gens (disons 50 % pour l'application, 40 % pour acheter/brûler, et 10 % pour l'entreprise)

ii) Une couche de liquidité stable avec M0, où un tas d'applications émettent leur propre stablecoin, mais la liquidité est unifiée

iii) Les deux options ci-dessus combinées avec les nouvelles chaînes de paiement générant de nouveaux revenus conduisent à environ 0 marge des émetteurs existants (puisqu'ils génèrent suffisamment de revenus de leurs chaînes en théorie), et ils dominent toujours

iv) L'idée du ticker de stablecoin est complètement abstraite

La deuxième option finit probablement par être similaire à Sanctum avec les LSTs sur Solana, où il y a un tas de LSTs, mais vraiment 2-3 dominent tout.

Je soupçonne que i) et iii) sont plus susceptibles de réussir à moyen terme puisque l'argent est une affaire d'effet de réseau.

Ce qui me conduit à penser que le jeu final est que vous ne voyez pas du tout le ticker. Les applications afficheront simplement "USD" au lieu de USDC, USDT ou USDX, et elles échangeront tout en arrière-plan via une interface standardisée.

C'est parce que c'est la solution optimale pour les applications dans un marché commodisé, et cela devient principalement un problème technologique via des interfaces et de la liquidité. Et si c'est la solution optimale, alors les gens vont rivaliser et itérer pour y parvenir.

La leçon du jour est que si vous êtes une application avec distribution, vous devriez pousser agressivement pour obtenir le meilleur accord possible maintenant que les vannes sont ouvertes.

Vous devriez également chercher à abstraire le ticker USD sur le frontend pour inciter les émetteurs à rivaliser tout en se commoditisant.

9,82K

Ces derniers jours, les discussions autour des layer2 d'Ethereum se sont intensifiées. Un membre de la SEC a déclaré dans un podcast que ceux qui dépendent de séquenceurs centralisés doivent être considérés comme des "échanges", et @Scroll_ZKP a également soudainement annoncé la suspension de la gouvernance DAO décentralisée. De plus, @Optimism a connu un certain nombre de départs de développeurs clés récemment. Le marché ressent de plus en plus d'hésitation et d'anxiété concernant les layer2 d'Ethereum, cette terrible dette technique d'Ethereum !

Voici mon point de vue personnel :

1) La question des séquenceurs décentralisés semble maintenant inopportune, car la plupart des layer2 principaux comme Arbitrum, Optimism, Base, etc., utilisent des séquenceurs centralisés. De plus, @VitalikButerin a proposé une feuille de route technique de stage0 à stage2 et a suggéré un chemin pragmatique pour des retraits en une heure. Bien que @MetisL2 ait réalisé un séquenceur décentralisé, cela reste un petit projet dans son propre écosystème.

Tout cela a une seule implication : le problème de la décentralisation des layer2 est temporairement insoluble. Donc, discuter de savoir si cela sera considéré comme un échange n'a pas beaucoup de sens ;

2) La suspension de la gouvernance DAO décentralisée par Scroll a des implications qui dépendent de votre interprétation. On peut dire que Scroll, qui ne pouvait pas réaliser les caractéristiques de confiance zéro du séquenceur décentralisé, n'a même pas pu maintenir la gouvernance DAO décentralisée, ce qui signifie que l'"expérience" du layer2 zkEVM décentralisé a échoué.

Mais ce n'est pas nécessairement une mauvaise chose. Cela pourrait aussi signifier que l'équipe, en cherchant à promouvoir la commercialisation, a trouvé la gouvernance DAO trop contraignante. Puisque le séquenceur ne peut pas être décentralisé, la décentralisation de la gouvernance DAO n'est qu'un formalisme. Pourquoi ne pas abandonner cela pour embrasser la flexibilité et l'efficacité ?

3) Les départs de développeurs clés de l'équipe @Optimism sont des événements qui illustrent la perte de pouvoir narratif technique des layer2 sur le marché. Il est essentiel de se demander pourquoi Hyperliquid et Stripe (Tempo) ont choisi de créer des chaînes indépendantes. Les chaînes qui dépendent encore de l'architecture technique des layer2, comme Base, ainsi que Robinhood et Upbit, vont-elles un jour se retirer des layer2 ? D'ailleurs, il y a aussi un camp L2, @megaeth_labs, qui attend l'évaluation du marché. Les layer2 manquent-ils vraiment d'un sol fertile pour une croissance durable ?

Tous ces signes indiquent que les layer2 génériques vont certainement perdre face aux layer1 à haute performance. S'appuyer uniquement sur l'héritage de sécurité d'Ethereum ne peut pas soutenir la prospérité de l'écosystème des layer2. Il faut soit se transformer en layer2 spécifiques pour rivaliser avec d'autres layer1, soit attendre un sacrifice sanglant.

Le processus de liquidation de la dette technique d'Ethereum pourrait être plus brutal que ce que tout le monde imagine.

olimpio11 sept., 02:42

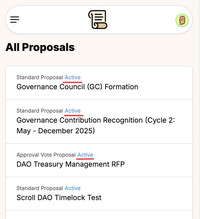

Aujourd'hui : la gouvernance de Scroll DAO 📜 va être "mise en pause"

La direction du DAO a démissionné, mais les propositions de gouvernance sont toujours en cours. Directement depuis l'appel des délégués d'aujourd'hui :

1. Haichen @shenhaichen (cofondateur de SCR) a commencé : ils "redessinent la gouvernance"

2. Raza @razacodes (membre de l'équipe SCR) : Ils ne veulent pas dire "STOP"/"Démanteler" la gouvernance, ils veulent dire "PAUSE". Beaucoup d'attention à la formulation.

3. Le débat est toujours en cours sur ce qu'il faut faire avec les propositions actuelles de ce cycle. Par exemple, il y a une proposition de gestion de trésorerie et ils doivent décider s'ils vont l'honorer ou non.

4. La direction du DAO (Eugene) a démissionné cette semaine

5. La direction de Scroll (Raza) ne savait pas entièrement quelles propositions étaient en cours, ni beaucoup de ce qui avait été approuvé dans le passé

6. Les raisons (et le processus) sont également flous pour le moment. Ils ont demandé du temps pour mettre tout en ordre et définir les prochaines étapes

7. Ils ont utilisé le mot "EXPÉRIMENT" plusieurs fois

8. Ils n'ont pas de vision claire des prochaines étapes pour l'instant

TLDR : ils redessinent la gouvernance, mais le chemin à suivre est flou ; il me semble qu'ils vont adopter une approche centralisée. Pas de communications claires pour l'instant, ni de transparence, ni de plan. Juste une annonce de "pause".

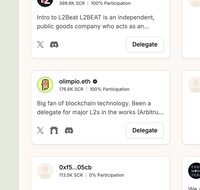

Pendant ce temps, olimpio reste au top #4 en pouvoir de gouvernance avec 176K SCR. Comme toujours, merci à tous les délégués 🫡. Je vous tiendrai au courant.

25,54K

Il y a deux choses qui, à première vue, n'ont rien à voir, mais que je trouve intéressantes à comparer : 1) @plumenetwork collabore avec Circle pour introduire l'USDC natif dans l'écosystème RWAFi ; 2) @HyperliquidX lance son stablecoin USDH par le biais d'enchères communautaires ;

1) L'adoption de l'USDC par Plume relève essentiellement d'une stratégie de "tirer parti des forces des autres", en intégrant le stablecoin le plus conforme pour accélérer l'afflux de fonds institutionnels, ce qui revient à choisir Circle comme "soutien officiel" à la stratégie RWA de Plume.

En revanche, Hyperliquid, qui a un volume de transactions quotidien atteignant des dizaines de milliards de dollars, lance le stablecoin USDH avec un objectif tout à fait opposé, clairement dans une démarche de "naviguer en mer", ne souhaitant pas toujours travailler pour les autres, car contrôler un stablecoin signifie avoir le pouvoir de tarification, et une série de bénéfices liés à la création, à la circulation et aux intérêts peuvent directement former un cercle financier ;

2) Pour Plume, l'intégration de l'USDC peut compléter son cercle commercial, en utilisant la conformité et la liquidité de l'USDC comme "appât à flux", attirant des fonds institutionnels, puis en dirigeant ces fonds vers son écosystème RWAFi pour gagner des frais de gestion et des parts de bénéfices grâce au mécanisme de création/rachat natif de pUSD et USDC, ainsi qu'au protocole de staking Nest associé.

En comparaison, USDH repose sur une logique complètement différente, Hyperliquid est essentiellement dans le business de "l'expansion du crédit", s'appuyant sur la crédibilité de la plateforme Hyperliquid qui traite des dizaines de milliards de dollars par jour.

6,69K

Meilleurs

Classement

Favoris