熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

這是本週的儀式研究摘要,一份涵蓋LLM世界和加密與AI交集最新動態的通訊。

每週有數百篇論文發表,跟上最新動態幾乎是不可能的。我們為您閱讀,所以您無需這樣做。

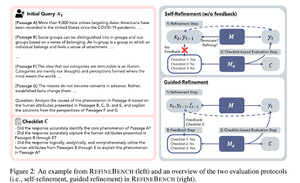

RefineBench:通過檢查清單評估語言模型的精煉能力

本文介紹了RefineBench,一個評估語言模型在各種場景下精煉能力的基準。它包含了自由形式和基於準確性的任務。

它涵蓋了人文學科、社會科學、法律和STEM領域的11個領域。這是以兩種方式進行評估的:自我精煉和引導精煉。在自我精煉的環境中,即使是前沿的語言模型得分也相對較低,而引導精煉則非常有效。

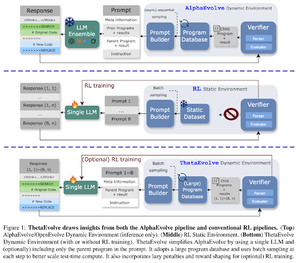

ThetaEvolve:在開放問題上的測試時學習

這篇論文提出了一個開源管道,用於解決具有挑戰性的問題。他們展示了 DeepSeek-R1-0528-Qwen3-8B 改善了在 AlphaEvolve 中考慮的一些開放問題的最佳已知界限。

RL 在 ThetaEvolve 上的表現超越了 2 個 OSS 模型和 4 個挑戰性問題的僅推理運行。他們顯示模型獲得了非平凡的能力,這從更好的分數和更快的進展中得以證明。這一改善甚至可以轉移到其他任務上。

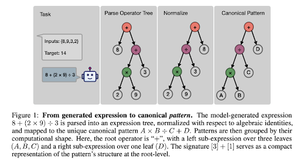

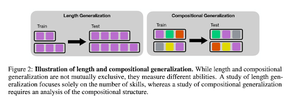

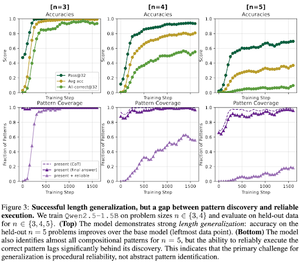

RL後訓練如何促進技能組合?以倒數為例

這篇論文探討了RL如何幫助模型學習通過倒數來組合技能。他們解開了長度和組合泛化的關係。

他們發現:

1) 模型能夠對更大的難題尺寸進行泛化

2) 圖案結構決定了難度

3) 模型能夠對未見過的圖案進行泛化

最終顯示出強化學習後訓練有助於長度泛化和部分組合泛化

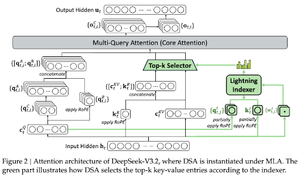

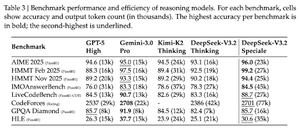

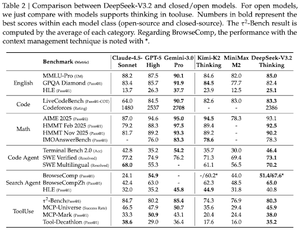

DeepSeek-V3.2:推進開放大型語言模型的邊界

這篇論文介紹了DS-V3.2,該模型採用了Deepseek稀疏注意力機制,以降低計算複雜度,同時在長上下文場景中保持性能。

對於強化學習後訓練,他們採用了專家蒸餾(根據領域專家的模型將數據蒸餾以訓練最終檢查點)和混合強化學習訓練(在一個階段合併推理、代理和人類對齊)。

他們使用DSmath-V2訓練了一個特殊模型,在國際數學奧林匹克中獲得金牌。

關注我們 @ritualdigest 獲取有關加密貨幣與 AI 研究的更多資訊,並且

@ritualnet 了解 Ritual 正在構建的內容。

349

熱門

排行

收藏