Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ось Ritual Research Digest цього тижня, інформаційний бюлетень, який висвітлює найновіші новини у світі LLM та перетин Crypto x AI.

З сотнями газет, що публікуються щотижня, залишатися в курсі останніх неможливо. Ми читаємо, щоб вам не доводилося цього робити.

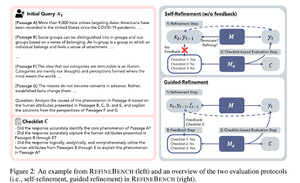

RefineBench: Оцінка здатності вдосконалення мовних моделей через контрольні списки

У цій статті представлено RefineBench — бенчмарк, який оцінює можливості удосконалення LM у різних сценаріях. Він включає як завдання вільної форми, так і на основі точності.

Вона охоплює 11 напрямків гуманітарних наук, соціальних наук, права та STEM. Це оцінюється двома способами: самовдосконалення та кероване вдосконалення. У системі самовдосконалення навіть фронтирні LM отримують відносно низькі бали, тоді як кероване доопрацювання є дуже ефективним.

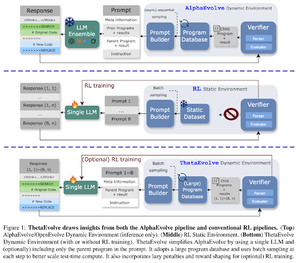

ThetaEvolve: Навчання під час тестування відкритих задач

У статті пропонується відкритий конвеєр для вирішення складних проблем. Вони показують, що DeepSeek-R1-0528-Qwen3-8B покращує найкращі відомі межі деяких відкритих задач, розглянутих у AlphaEvolve.

RL на ThetaEvolve перевершує запуски лише на основі виведення у 2 моделях OSS і 4 складних задачах. Вони показують, що модель набуває нетривіальних можливостей, що підтверджується кращими результатами та швидшим прогресом. Це покращення переноситься навіть на інші завдання.

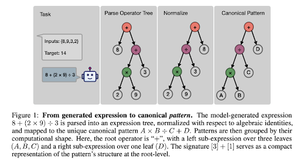

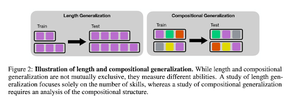

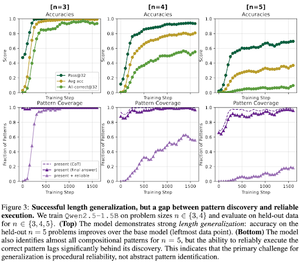

Як RL після тренування стимулює створення навичок? Кейс-стаді Countdown

У статті розглядається, як RL може допомогти моделі навчитися навичкам композиції за допомогою зворотного відліку. Вони розплутують узагальнення довжини та композиції.

Вони виявили, що:

1) Моделі узагальнюються на більші розміри головоломок

2) Структура патернів визначає складність

3) Моделі узагальнюються на невидимі закономірності

Зрештою, показано, що RL після тренування допомагає узагальнювати довжину та часткову композиційну узагальнення

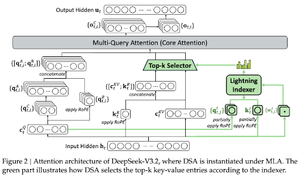

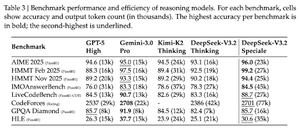

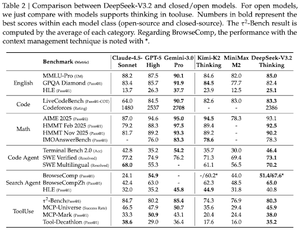

DeepSeek-v3.2: Розширення межі відкритих великих мовних моделей

У статті представлено DS-V3.2, який включає Deepseek sparse attention для зниження обчислювальної складності, зберігаючи продуктивність у довготривалих сценаріях.

Для RL postraining використовують спеціалізовану дистиляцію (експертні моделі для кожного домену дистилюються для навчання фінальної контрольної точки) та змішане RL-навчання (merge reasoning, agent and human alignment на одному етапі).

Вони навчають спеціалізовану модель за DSmath-V2, здобувши золото на мою думку.

Слідкуйте за нами @ritualdigest, щоб дізнатися більше про все, що стосується досліджень crypto x AI, а також

@ritualnet дізнатися більше про те, що будує Ritual.

358

Найкращі

Рейтинг

Вибране