Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tässä on tämän viikon Ritual Research Digest, uutiskirje, joka kattaa viimeisimmät tiedot LLM:ien maailmasta ja Crypto x AI:n risteyskohdasta.

Viikoittain julkaistaan satoja lehtiä, joten on mahdotonta pysyä ajan tasalla uusimmasta uutisesta. Me teemme lukemisen, jotta sinun ei tarvitse.

RefineBench: Kielimallien hienosäätökyvyn arviointi tarkistuslistojen avulla

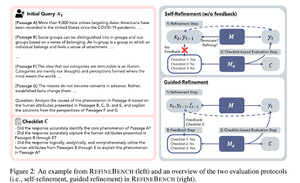

Tässä artikkelissa esitellään RefineBench, benchmarkin, joka arvioi LM:ien hienosäätökykyjä eri tilanteissa. Se sisältää sekä vapaamuotoisia että tarkkuuteen perustuvia tehtäviä.

Se kattaa 11 alaa humanistisissa tieteissä, yhteiskuntatieteissä, oikeustieteessä ja STEM-aloilla. Tätä arvioidaan kahdella tavalla: itsensä hienosäätönä ja ohjattuna hienosäätönä. Itsensä kehittämisessä jopa rajaseudun LM:t saavat suhteellisen matalat pisteet, kun taas ohjattu jalostus on erittäin tehokasta.

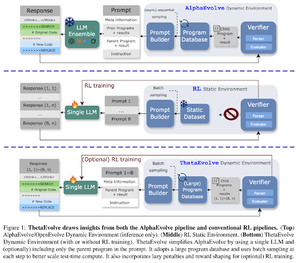

ThetaEvolve: Testiaikainen oppiminen avoimista ongelmista

Artikkelissa ehdotetaan avoimen lähdekoodin putkistoa haastavien ongelmien ratkaisemiseksi. Ne osoittavat, että DeepSeek-R1-0528-Qwen3-8B parantaa joidenkin AlphaEvolvessa käsiteltyjen avoimien ongelmien parhaiten tunnettuja rajoja.

RL ThetaEvolvella päihittää pelkästään päättelyyn perustuvat suoritukset kahdessa OSS-mallissa ja neljässä haastavassa ongelmassa. Ne osoittavat, että malli saa ei-triviaaleja ominaisuuksia, kuten paremmat pisteet ja nopeampi edistyminen osoittavat. Tämä parannus siirtyy myös muihin tehtäviin.

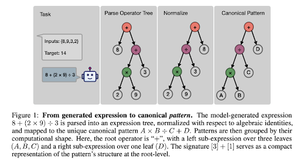

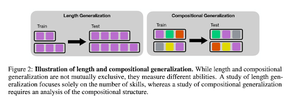

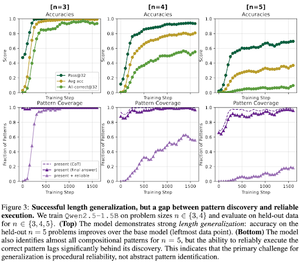

Miten RL:n jälkeinen koulutus edistää taitojen muodostamista? Tapaustutkimus Countdownista

Artikkelissa tutkitaan, miten RL voi auttaa mallia oppimaan kirjoittamisen taitoja laskurin avulla. Ne purkavat pituuden ja sommittelullisen yleistyksen.

He havaitsevat, että:

1) Mallit yleistetään suurempiin pulmien kokoihin

2) Kuviorakenne määrittää vaikeustason

3) Mallit yleistävät näkymättömiin kuvioihin

Lopulta osoittaen, että RL:n jälkeinen koulutus auttaa pituusyleistyksessä ja osittaisessa koostumuksen yleistyksessä

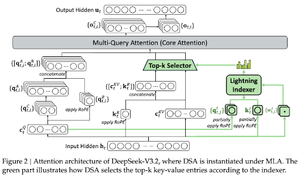

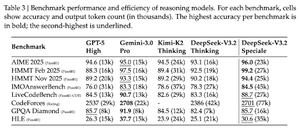

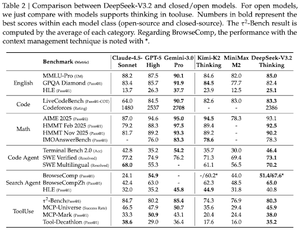

DeepSeek-V3.2: Avoimien suurten kielimallien rajojen rikkominen

Artikkelissa esitellään DS-V3.2, joka hyödyntää Deepseekin harvaa huomiota laskennallisen monimutkaisuuden vähentämiseksi ja suorituskyvyn säilyttämiseksi pitkissä tilanteissa.

RL-postrainingissa käytetään erikoistunutta tislausta (per domain expert -mallit tislataan dataa lopullisen tarkistuspisteen kouluttamiseksi) ja sekoitettua RL-koulutusta (yhdistämispäättely, agentti ja ihmisen kohdistus yhdessä vaiheessa).

He kouluttavat erikoismallia käyttäen DSmath-V2:ta, saavuttaen kultaa mielestäni arvossa.

Seuraa meitä @ritualdigest saadaksesi lisätietoja kaikesta krypto x AI -tutkimuksesta ja

@ritualnet oppia lisää siitä, mitä Ritual rakentaa.

370

Johtavat

Rankkaus

Suosikit