Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Đây là bản Digest Nghiên cứu Ritual của tuần này, một bản tin bao quát những điều mới nhất trong thế giới LLM và giao thoa giữa Crypto x AI.

Với hàng trăm tài liệu được công bố hàng tuần, việc cập nhật những điều mới nhất là điều không thể. Chúng tôi làm việc đọc để bạn không phải làm.

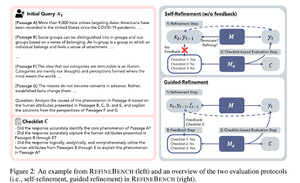

RefineBench: Đánh giá khả năng tinh chỉnh của các mô hình ngôn ngữ thông qua danh sách kiểm tra

Bài báo này giới thiệu RefineBench, một tiêu chuẩn đánh giá khả năng tinh chỉnh của các mô hình ngôn ngữ trong nhiều tình huống khác nhau. Nó bao gồm cả các nhiệm vụ tự do và dựa trên độ chính xác.

Nó bao gồm 11 lĩnh vực trong nhân văn, khoa học xã hội, luật và các lĩnh vực STEM. Điều này được đánh giá theo 2 cách: tự cải tiến và cải tiến có hướng dẫn. Trong một môi trường tự cải tiến, ngay cả các mô hình ngôn ngữ tiên tiến cũng có điểm số tương đối thấp, trong khi cải tiến có hướng dẫn lại rất hiệu quả.

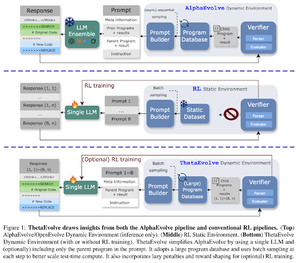

ThetaEvolve: Học tập trong thời gian thử nghiệm trên các vấn đề mở

Bài báo đề xuất một quy trình mã nguồn mở để giải quyết các vấn đề khó khăn. Họ cho thấy rằng DeepSeek-R1-0528-Qwen3-8B, cải thiện các giới hạn tốt nhất đã biết của một số vấn đề mở được xem xét trong AlphaEvolve.

RL trên ThetaEvolve vượt trội hơn so với các lần chạy chỉ suy diễn trên 2 mô hình OSS và 4 vấn đề thách thức. Họ cho thấy rằng mô hình có được những khả năng không tầm thường, như được chứng minh bởi điểm số tốt hơn và tiến bộ nhanh hơn. Sự cải thiện này thậm chí còn chuyển giao sang các nhiệm vụ khác.

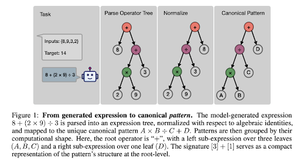

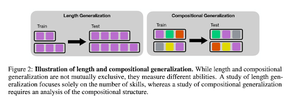

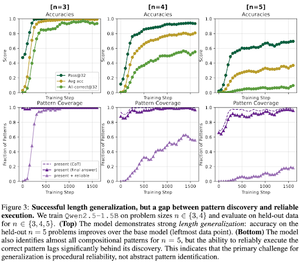

RL sau đào tạo tác động đến việc kết hợp kỹ năng như thế nào? Một nghiên cứu trường hợp về Countdown

Bài báo khám phá cách mà RL có thể giúp một mô hình học cách kết hợp các kỹ năng với sự trợ giúp của countdown. Họ phân tách độ dài và sự tổng quát kết hợp.

Họ nhận thấy rằng:

1) Các mô hình tổng quát cho kích thước câu đố lớn hơn

2) Cấu trúc mẫu xác định độ khó

3) Các mô hình tổng quát cho các mẫu chưa thấy

Cuối cùng cho thấy rằng việc huấn luyện sau RL giúp tổng quát độ dài và tổng quát thành phần một phần.

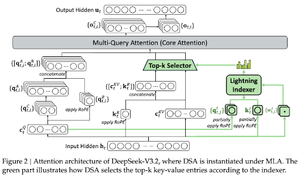

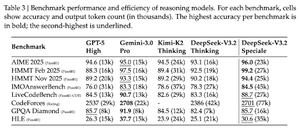

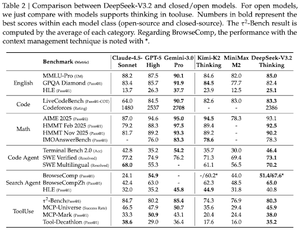

DeepSeek-V3.2: Đẩy mạnh Frontier của các Mô hình Ngôn ngữ Lớn Mở

Bài báo giới thiệu DS-V3.2, tích hợp sự chú ý thưa của Deepseek để giảm độ phức tạp tính toán trong khi vẫn duy trì hiệu suất trong các tình huống ngữ cảnh dài.

Đối với việc huấn luyện sau RL, họ sử dụng tinh chế chuyên gia (theo mô hình chuyên gia miền, dữ liệu được tinh chế để huấn luyện điểm kiểm tra cuối cùng) và huấn luyện RL hỗn hợp (kết hợp lý luận, tác nhân và sự đồng bộ của con người trong một giai đoạn).

Họ huấn luyện một mô hình đặc biệt sử dụng DSmath-V2, đạt huy chương vàng trong IMO.

Theo dõi chúng tôi @ritualdigest để biết thêm về tất cả các vấn đề liên quan đến nghiên cứu crypto x AI, và

@ritualnet để tìm hiểu thêm về những gì Ritual đang xây dựng.

363

Hàng đầu

Thứ hạng

Yêu thích