Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Вот дайджест Ritual Research за эту неделю, информационный бюллетень, охватывающий последние события в мире LLM и пересечении Crypto x AI.

С сотнями статей, публикуемых еженедельно, оставаться в курсе последних новостей невозможно. Мы читаем, чтобы вам не пришлось.

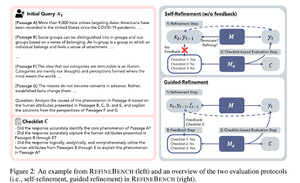

RefineBench: Оценка возможностей доработки языковых моделей с помощью контрольных списков

В этой статье представлен RefineBench, бенчмарк, который оценивает возможности доработки языковых моделей в различных сценариях. Он включает как задачи свободной формы, так и задачи, основанные на точности.

Он охватывает 11 областей в гуманитарных науках, социальных науках, праве и STEM-дисциплинах. Это оценивается двумя способами: самосовершенствование и направленное совершенствование. В условиях самосовершенствования даже передовые языковые модели показывают относительно низкие результаты, в то время как направленное совершенствование оказывается очень эффективным.

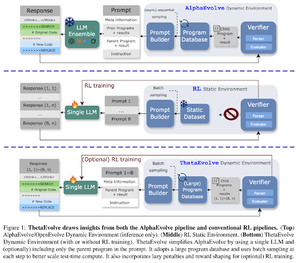

ThetaEvolve: Обучение во время тестирования на открытых задачах

В статье предлагается открытая платформа для решения сложных задач. Они показывают, что DeepSeek-R1-0528-Qwen3-8B улучшает наилучшие известные границы некоторых открытых задач, рассматриваемых в AlphaEvolve.

RL на ThetaEvolve превосходит только инференсные запуски по 2 OSS моделям и 4 сложным задачам. Они показывают, что модель приобретает значительные возможности, о чем свидетельствуют лучшие результаты и более быстрый прогресс. Это улучшение даже переносится на другие задачи.

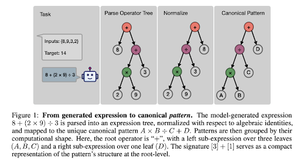

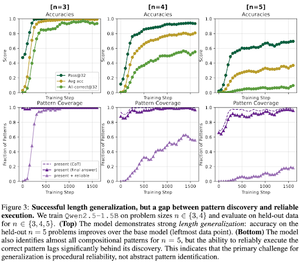

Как RL после обучения способствует составлению навыков? Пример на основе обратного отсчета

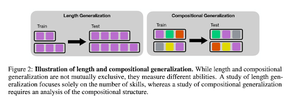

В статье рассматривается, как RL может помочь модели научиться составлять навыки с помощью обратного отсчета. Они разделяют длину и обобщение композиции.

Они обнаруживают, что:

1) Модели обобщаются на более крупные размеры головоломок

2) Структура паттерна определяет сложность

3) Модели обобщаются на невидимые паттерны

В конечном итоге показывая, что RL после обучения помогает обобщению длины и частичному композицийному обобщению

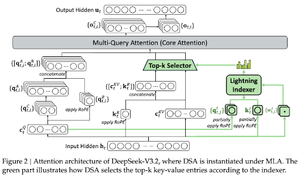

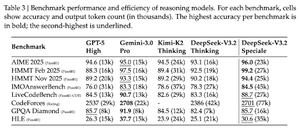

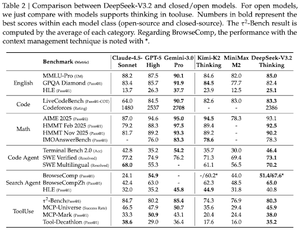

DeepSeek-V3.2: Продвижение границ открытых больших языковых моделей

В статье представлена DS-V3.2, которая включает разреженное внимание Deepseek для снижения вычислительной сложности при сохранении производительности в сценариях с длинным контекстом.

Для посттренировки RL они используют специализированную дистилляцию (по моделям доменных экспертов данные дистиллируются для обучения финальной контрольной точки) и смешанное обучение RL (объединение рассуждений, агента и человеческой согласованности на одном этапе).

Они обучают специальную модель, используя DSmath-V2, достигая золота на IMO.

Подписывайтесь на нас @ritualdigest, чтобы узнать больше о всем, что связано с криптовалютой и исследованиями в области ИИ, а также @ritualnet, чтобы узнать больше о том, что строит Ritual.

367

Топ

Рейтинг

Избранное