Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Oto najnowszy Digest Ritual Research, newsletter obejmujący najnowsze wydarzenia w świecie LLM-ów oraz na styku Crypto x AI.

Z setkami publikacji co tydzień, niemożliwe jest nadążanie za nowinkami. My czytamy, abyś nie musiał.

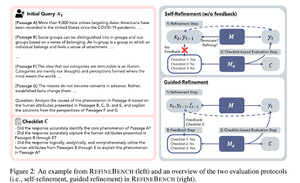

RefineBench: Ocena zdolności do udoskonalania modeli językowych za pomocą list kontrolnych

Niniejszy artykuł wprowadza RefineBench, benchmark, który ocenia zdolności do udoskonalania modeli językowych w różnych scenariuszach. Zawiera zarówno zadania o swobodnej formie, jak i oparte na dokładności.

Obejmuje 11 dziedzin w zakresie nauk humanistycznych, nauk społecznych, prawa i STEM. Jest to oceniane na 2 sposoby: samodoskonalenie i ukierunkowane doskonalenie. W ustawieniu samodoskonalenia, nawet najnowocześniejsze modele językowe osiągają stosunkowo niskie wyniki, podczas gdy ukierunkowane doskonalenie jest bardzo skuteczne.

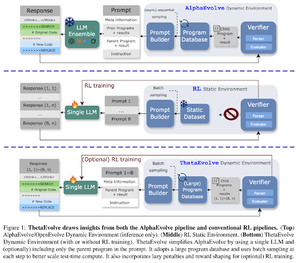

ThetaEvolve: Uczenie w czasie testu na otwartych problemach

Artykuł proponuje otwartą pipeline do rozwiązywania trudnych problemów. Pokazują, że DeepSeek-R1-0528-Qwen3-8B poprawia najlepsze znane granice niektórych otwartych problemów rozważanych w AlphaEvolve.

RL na ThetaEvolve przewyższa wyniki tylko na podstawie wnioskowania w dwóch modelach OSS i czterech trudnych problemach. Pokazują, że model zyskuje istotne zdolności, co potwierdzają lepsze wyniki i szybszy postęp. Ta poprawa przenosi się nawet na inne zadania.

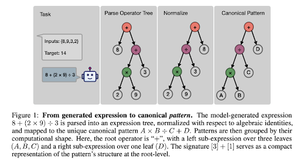

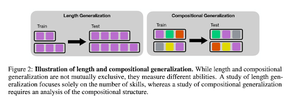

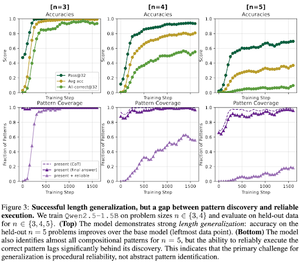

Jak RL po treningu indukuje kompozycję umiejętności? Studium przypadku na temat odliczania

Artykuł bada, w jaki sposób RL może pomóc modelowi nauczyć się komponować umiejętności z pomocą odliczania. Rozdzielają długość i generalizację kompozycyjną.

Oni odkrywają, że:

1) Modele generalizują do większych rozmiarów puzzli

2) Struktura wzoru determinuje trudność

3) Modele generalizują do niewidzianych wzorów

Ostatecznie pokazując, że RL po treningu wspomaga generalizację długości i częściową generalizację kompozycyjną

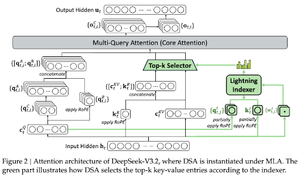

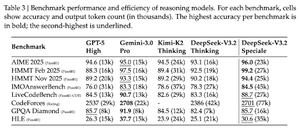

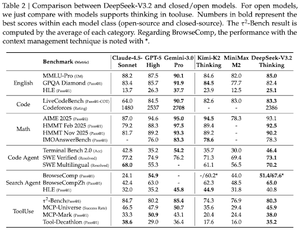

DeepSeek-V3.2: Pushing the Frontier of Open Large Language Models

Artykuł wprowadza DS-V3.2, który wykorzystuje rzadką uwagę Deepseek, aby zmniejszyć złożoność obliczeniową przy jednoczesnym zachowaniu wydajności w scenariuszach z długim kontekstem.

W przypadku post-treningu RL stosują destylację specjalistyczną (modele ekspertów dziedzinowych są destylowane z danych, aby wytrenować ostateczny punkt kontrolny) oraz mieszany trening RL (łączenie rozumowania, agenta i dostosowania do ludzi w jednym etapie).

Trenują specjalny model używając DSmath-V2, osiągając złoto w IMO.

Śledź nas @ritualdigest, aby uzyskać więcej informacji na temat wszystkiego, co związane z kryptowalutami i badaniami AI, oraz @ritualnet, aby dowiedzieć się więcej o tym, co buduje Ritual.

361

Najlepsze

Ranking

Ulubione