Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Digest de Investigación Ritual de esta semana, un boletín que cubre lo último en el mundo de los LLM y la intersección de Crypto x AI.

Con cientos de artículos publicados semanalmente, mantenerse al día con lo último es imposible. Hacemos la lectura para que tú no tengas que hacerlo.

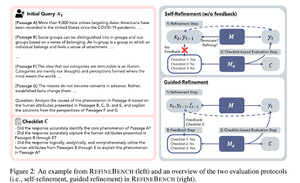

RefineBench: Evaluación de la capacidad de refinamiento de los modelos de lenguaje a través de listas de verificación

Este artículo presenta RefineBench, un banco de pruebas que evalúa las capacidades de refinamiento de los modelos de lenguaje en varios escenarios. Incorpora tanto tareas de forma libre como basadas en la precisión.

Cubre 11 dominios en humanidades, ciencias sociales, derecho y dominios STEM. Esto se evalúa de 2 maneras: auto-refinamiento y refinamiento guiado. En un entorno de auto-refinamiento, incluso los LMs de frontera obtienen puntuaciones relativamente bajas, mientras que el refinamiento guiado es muy efectivo.

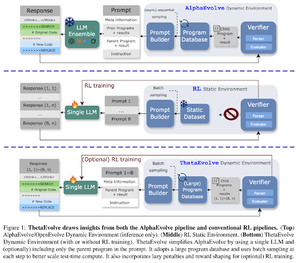

ThetaEvolve: Aprendizaje en tiempo de prueba sobre problemas abiertos

El artículo propone una pipeline de código abierto para abordar problemas desafiantes. Muestran que DeepSeek-R1-0528-Qwen3-8B mejora los mejores límites conocidos de algunos problemas abiertos considerados en AlphaEvolve.

RL en ThetaEvolve supera las ejecuciones solo de inferencia en 2 modelos OSS y 4 problemas desafiantes. Muestran que el modelo adquiere capacidades no triviales, como lo evidencian mejores puntuaciones y un progreso más rápido. Esta mejora incluso se transfiere a otras tareas.

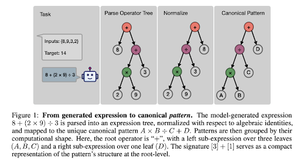

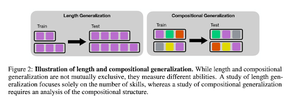

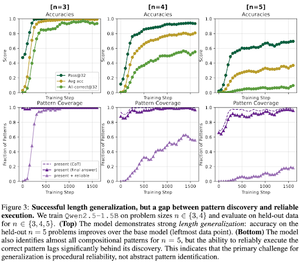

¿Cómo induce el entrenamiento posterior de RL la composición de habilidades? Un estudio de caso sobre Countdown

El artículo explora cómo RL puede ayudar a un modelo a aprender a componer habilidades con la ayuda de countdown. Desentrañan la longitud y la generalización composicional.

Encuentran que:

1) Los modelos se generalizan a tamaños de rompecabezas más grandes

2) La estructura del patrón determina la dificultad

3) Los modelos se generalizan a patrones no vistos

Mostrando en última instancia que el entrenamiento posterior con RL ayuda a la generalización de longitud y a la generalización composicional parcial

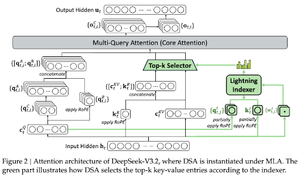

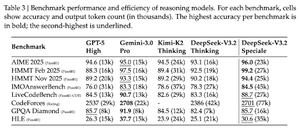

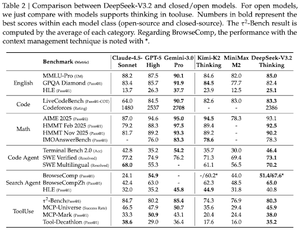

DeepSeek-V3.2: Impulsando la Frontier de los Modelos de Lenguaje Abiertos de Gran Tamaño

El documento presenta DS-V3.2, que incorpora la atención dispersa de Deepseek para reducir la complejidad computacional mientras preserva el rendimiento en escenarios de contexto largo.

Para el postentrenamiento de RL, emplean la destilación especializada (según modelos de expertos en el dominio, los datos se destilan para entrenar el punto de control final) y el entrenamiento de RL mixto (fusionan el razonamiento, el agente y la alineación humana en una sola etapa).

Entrenan un modelo especial utilizando DSmath-V2, logrando oro en IMO.

Síguenos en @ritualdigest para más información sobre todo lo relacionado con la investigación en cripto x IA, y

@ritualnet para aprender más sobre lo que Ritual está construyendo.

370

Parte superior

Clasificación

Favoritos