Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Her er denne ukens Ritual Research Digest, et nyhetsbrev som dekker det siste i verden av LLM-er og skjæringspunktet mellom Crypto x AI.

Med hundrevis av artikler utgitt ukentlig, er det umulig å holde seg oppdatert med det siste. Vi leser slik at du ikke trenger å gjøre det.

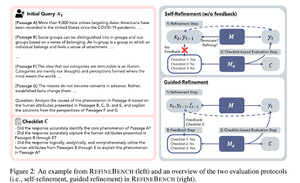

RefineBench: Evaluering av forbedringsevnen til språkmodeller via sjekklister

Denne artikkelen introduserer RefineBench, en benchmark som evaluerer forbedringsevner for LM-er i ulike scenarioer. Den inkluderer både friformede og nøyaktighetsbaserte oppgaver.

Den dekker 11 domener innen humaniora, samfunnsvitenskap, jus og realfag. Dette vurderes på to måter: selvforbedring og veiledet raffinering. I en selvforbedringssetting scorer selv grense-LM-er relativt lavt, mens veiledet forbedring er svært effektivt.

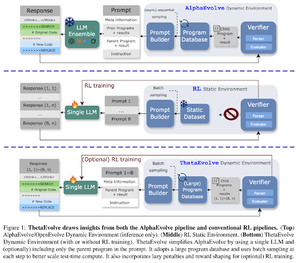

ThetaEvolve: Testtidslæring på åpne problemer

Artikkelen foreslår en åpen kildekode-pipeline for å takle utfordrende problemer. De viser at DeepSeek-R1-0528-Qwen3-8B , forbedrer de best kjente grensene for noen åpne problemer vurdert i AlphaEvolve.

RL på ThetaEvolve overgår kun inferenskjøringer på tvers av 2 OSS-modeller og 4 utfordrende problemer. De viser at modellen får ikke-trivielle evner, noe som vises ved bedre poengsummer og raskere fremgang. Denne forbedringen overføres til og med til andre oppgaver.

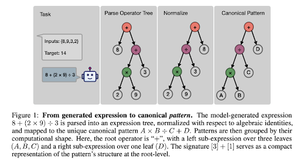

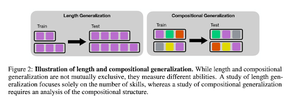

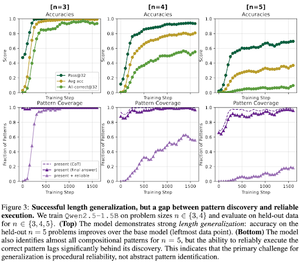

Hvordan fremmer RL etter trening ferdighetssammensetning? En casestudie om nedtelling

Artikkelen utforsker hvordan RL kan hjelpe en modell med å lære å komponere ferdigheter ved hjelp av nedtelling. De skiller ut lengden og den komposisjonelle generaliseringen.

De finner at:

1) Modellene generaliseres til større puslespillstørrelser

2) Mønsterstruktur bestemmer vanskelighetsgraden

3) Modeller generaliseres til usynlige mønstre

Til slutt hjelper det å vise at RL etter trening bidrar til varighetsgeneralisering og delvis komposisjonsgeneralisering

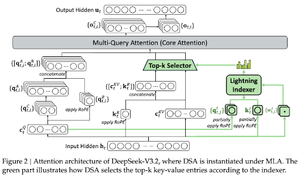

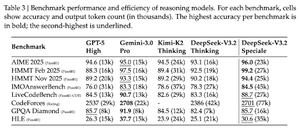

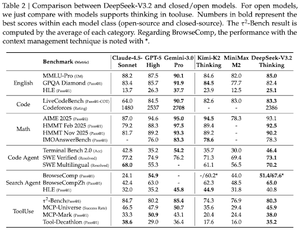

DeepSeek-v3.2: Å presse grensen for åpne store språkmodeller

Artikkelen introduserer DS-V3.2, som inkorporerer Deepseek sparsom oppmerksomhet for å redusere beregningskompleksiteten samtidig som ytelsen i langtidskontekstscenarier bevares.

For RL-postraining benytter de spesialisert destillasjon (ekspertmodeller per domene destilleres data for å trene siste sjekkpunkt) og blandet RL-trening (sammenslåing av resonnement, agent og menneskelig tilpasning i ett trinn).

De trener en spesialmodell med DSmath-V2, og oppnår gull i IMO.

Følg oss @ritualdigest for mer om alt som har med krypto x AI-forskning å gjøre, og

@ritualnet lære mer om hva Ritual bygger.

351

Topp

Rangering

Favoritter