Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier ist der Ritual Research Digest dieser Woche, ein Newsletter, der die neuesten Entwicklungen in der Welt der LLMs und der Schnittstelle von Crypto x AI abdeckt.

Mit Hunderten von wöchentlich veröffentlichten Arbeiten ist es unmöglich, auf dem neuesten Stand zu bleiben. Wir lesen für Sie, damit Sie es nicht müssen.

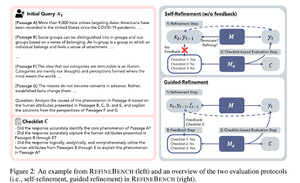

RefineBench: Bewertung der Verfeinerungsfähigkeit von Sprachmodellen mittels Checklisten

Dieses Papier stellt RefineBench vor, ein Benchmark, das die Verfeinerungsfähigkeiten von LMs in verschiedenen Szenarien bewertet. Es umfasst sowohl freie als auch genauigkeitsbasierte Aufgaben.

Es deckt 11 Bereiche in den Geisteswissenschaften, Sozialwissenschaften, Recht und MINT-Bereichen ab. Dies wird auf 2 Arten bewertet: Selbstverfeinerung und geführte Verfeinerung. In einem Selbstverfeinerungsszenario erzielen selbst fortschrittliche LMs relativ niedrige Werte, während geführte Verfeinerung sehr effektiv ist.

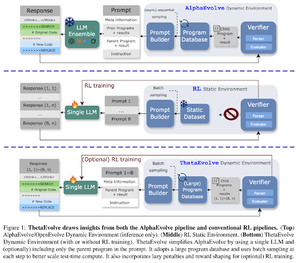

ThetaEvolve: Lernen zur Testzeit bei offenen Problemen

Das Papier schlägt eine Open-Source-Pipeline zur Bewältigung herausfordernder Probleme vor. Sie zeigen, dass DeepSeek-R1-0528-Qwen3-8B die besten bekannten Grenzen einiger offener Probleme, die in AlphaEvolve betrachtet werden, verbessert.

RL auf ThetaEvolve übertrifft Inferenz-nur Läufe über 2 OSS-Modelle und 4 herausfordernde Probleme. Sie zeigen, dass das Modell nicht triviale Fähigkeiten erlangt, wie durch bessere Ergebnisse und schnelleren Fortschritt belegt. Diese Verbesserung überträgt sich sogar auf andere Aufgaben.

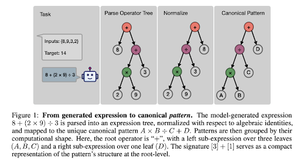

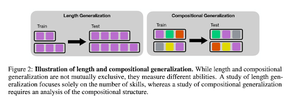

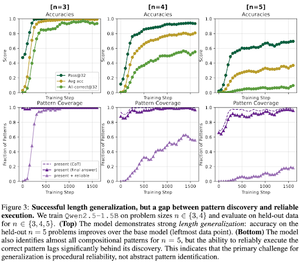

Wie induziert RL nach dem Training die Zusammensetzung von Fähigkeiten? Eine Fallstudie zu Countdown

Das Papier untersucht, wie RL einem Modell helfen kann, Fähigkeiten mit Hilfe von Countdown zu komponieren. Sie entwirren die Länge und die kompositionale Generalisierung.

Sie stellen fest, dass:

1) Modelle auf größere Puzzlegrößen verallgemeinern

2) Die Struktur des Musters die Schwierigkeit bestimmt

3) Modelle auf ungesehene Muster verallgemeinern

Letztendlich zeigt sich, dass das RL-Post-Training die Längengeneralisierung und die partielle kompositionale Generalisierung unterstützt.

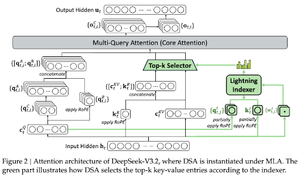

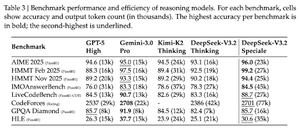

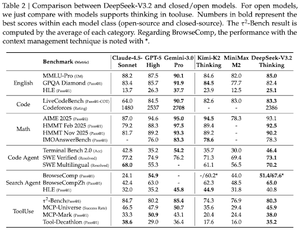

DeepSeek-V3.2: Die Grenzen der offenen großen Sprachmodelle verschieben

Das Papier stellt DS-V3.2 vor, das Deepseek-sparsame Aufmerksamkeit integriert, um die Rechenkomplexität zu reduzieren und gleichzeitig die Leistung in Szenarien mit langem Kontext zu erhalten.

Für das RL-Nachtraining setzen sie spezialisierte Distillation ein (gemäß den Modellen von Domänenexperten werden Daten destilliert, um den endgültigen Checkpoint zu trainieren) und gemischtes RL-Training (Vereinigung von Schlussfolgerungen, Agent und menschlicher Ausrichtung in einer Phase).

Sie trainieren ein spezielles Modell mit DSmath-V2 und erreichen Gold bei der IMO.

Folge uns @ritualdigest für mehr über alles, was mit Krypto x AI-Forschung zu tun hat, und @ritualnet, um mehr darüber zu erfahren, was Ritual aufbaut.

360

Top

Ranking

Favoriten