Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ecco il Digest di Ricerca Rituale di questa settimana, una newsletter che copre le ultime novità nel mondo dei LLM e l'intersezione tra Crypto e AI.

Con centinaia di articoli pubblicati settimanalmente, rimanere aggiornati con le ultime novità è impossibile. Noi facciamo la lettura così non dovete farlo voi.

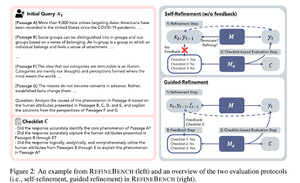

RefineBench: Valutazione della capacità di raffinamento dei modelli linguistici tramite checklist

Questo documento introduce RefineBench, un benchmark che valuta le capacità di raffinamento dei modelli linguistici in vari scenari. Include sia compiti a forma libera che basati sull'accuratezza.

Copre 11 ambiti nelle scienze umane, nelle scienze sociali, nel diritto e nelle discipline STEM. Questo viene valutato in 2 modi: auto-affinamento e affinamento guidato. In un contesto di auto-affinamento, anche i modelli di linguaggio all'avanguardia ottengono punteggi relativamente bassi, mentre l'affinamento guidato è molto efficace.

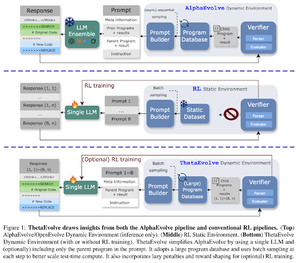

ThetaEvolve: Apprendimento al test su problemi aperti

Il documento propone una pipeline open source per affrontare problemi complessi. Dimostrano che DeepSeek-R1-0528-Qwen3-8B migliora i migliori limiti conosciuti di alcuni problemi aperti considerati in AlphaEvolve.

RL su ThetaEvolve supera le esecuzioni solo di inferenza su 2 modelli OSS e 4 problemi impegnativi. Dimostrano che il modello acquisisce capacità non banali, come evidenziato da punteggi migliori e progressi più rapidi. Questo miglioramento si trasferisce anche ad altri compiti.

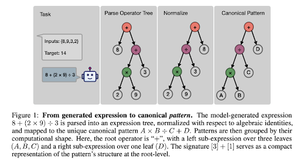

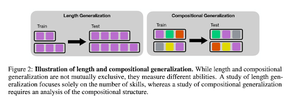

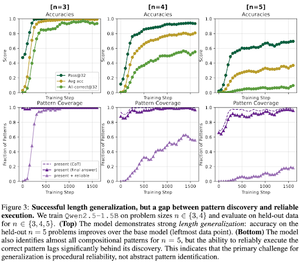

Come induce la post-formazione di RL la composizione delle abilità? Uno studio di caso su Countdown

Il documento esplora come RL può aiutare un modello a imparare a comporre abilità con l'aiuto del countdown. Disaggregano la lunghezza e la generalizzazione compositiva.

Scoprono che:

1) I modelli si generalizzano a dimensioni di puzzle più grandi

2) La struttura del pattern determina la difficoltà

3) I modelli si generalizzano a pattern mai visti

Dimostrando infine che il RL dopo l'addestramento aiuta la generalizzazione della lunghezza e la generalizzazione compositiva parziale

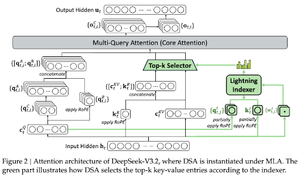

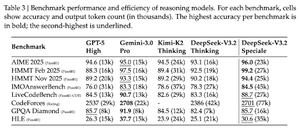

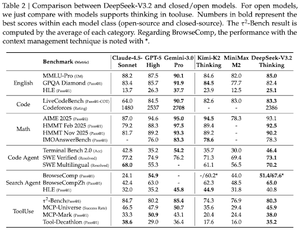

DeepSeek-V3.2: Spingere il Frontier dei Modelli Linguistici Open di Grandi Dimensioni

Il documento introduce DS-V3.2, che incorpora l'attenzione sparsa di Deepseek per ridurre la complessità computazionale mantenendo le prestazioni in scenari di lungo contesto.

Per il post-addestramento RL, utilizzano la distillazione specialistica (per i modelli esperti di dominio, i dati vengono distillati per addestrare il checkpoint finale) e l'addestramento RL misto (unire il ragionamento, l'agente e l'allineamento umano in un'unica fase).

Addestrano un modello speciale utilizzando DSmath-V2, ottenendo l'oro nell'IMO.

Seguici su @ritualdigest per ulteriori informazioni su tutto ciò che riguarda la ricerca crypto x AI, e

@ritualnet per saperne di più su cosa sta costruendo Ritual.

355

Principali

Ranking

Preferiti