Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die de laatste ontwikkelingen in de wereld van LLM's en de kruising van Crypto x AI behandelt.

Met honderden gepubliceerde artikelen per week is het onmogelijk om bij te blijven met het laatste nieuws. Wij doen het lezen zodat jij dat niet hoeft te doen.

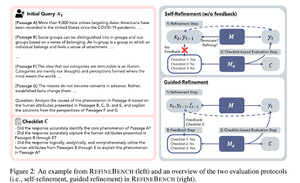

RefineBench: Evaluatie van de verfijningscapaciteit van taalmodellen via checklists

Dit paper introduceert RefineBench, een benchmark die de verfijningscapaciteiten van taalmodellen in verschillende scenario's evalueert. Het omvat zowel vrije vorm als op nauwkeurigheid gebaseerde taken.

Het dekt 11 domeinen binnen de geesteswetenschappen, sociale wetenschappen, recht en STEM-domeinen. Dit wordt op 2 manieren geëvalueerd: zelfverbetering en begeleide verbetering. In een zelfverbeteringsinstelling scoren zelfs grensverleggende LMs relatief laag, terwijl begeleide verbetering zeer effectief is.

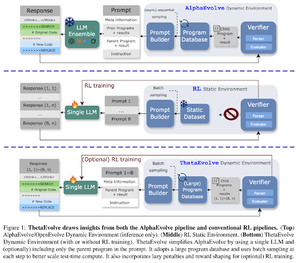

ThetaEvolve: Leren tijdens de testfase op open problemen

Het paper stelt een opensource-pijplijn voor om uitdagende problemen aan te pakken. Ze tonen aan dat DeepSeek-R1-0528-Qwen3-8B de best bekende grenzen van enkele open problemen die in AlphaEvolve worden beschouwd, verbetert.

RL op ThetaEvolve presteert beter dan alleen inferentie-runs over 2 OSS-modellen en 4 uitdagende problemen. Ze tonen aan dat het model niet-triviale capaciteiten verwerft, zoals blijkt uit betere scores en snellere vooruitgang. Deze verbetering wordt zelfs overgedragen naar andere taken.

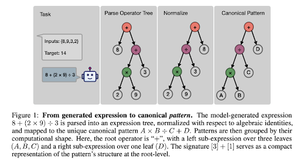

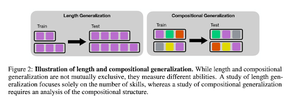

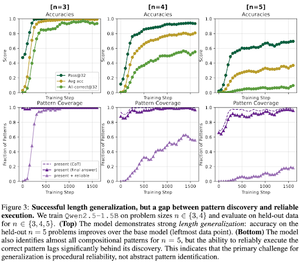

Hoe induceert RL post-training vaardigheidscompositie? Een casestudy over Countdown

Het paper onderzoekt hoe RL een model kan helpen om vaardigheden te leren samenstellen met behulp van countdown. Ze ontrafelen de lengte en compositie-generalizatie.

Ze ontdekken dat:

1) Modellen generaliseren naar grotere puzzelgroottes

2) Patroonstructuur bepaalt de moeilijkheidsgraad

3) Modellen generaliseren naar ongeziene patronen

Uiteindelijk toont het aan dat RL-nabehandeling helpt bij lengtegeneralizatie en gedeeltelijke compositional generalizatie

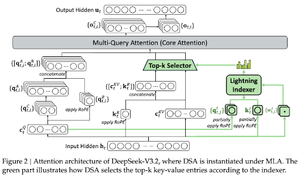

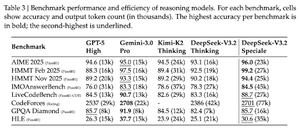

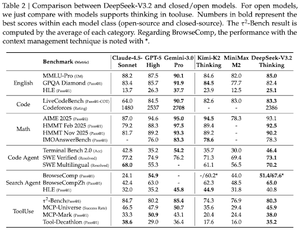

DeepSeek-V3.2: De Frontier van Open Grote Taalmodellen Verleggen

Het paper introduceert DS-V3.2, dat Deepseek-sparse aandacht incorporeert om de rekencomplexiteit te verminderen terwijl de prestaties in lange contextscenario's behouden blijven.

Voor RL posttraining maken ze gebruik van specialistische distillatie (per domeinexpertmodellen worden gegevens gedistilleerd om de uiteindelijke checkpoint te trainen) en gemengde RL-training (reden, agent en menselijke afstemming in één fase samenvoegen).

Ze trainen een speciaal model met DSmath-V2 en behalen goud op de IMO.

Volg ons @ritualdigest voor meer over alles wat met crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

368

Boven

Positie

Favorieten