トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

今週の Ritual Research Digest は、LLM の世界の最新情報と Crypto x AI の交差点をカバーするニュースレターです。

毎週何百もの論文が発行されているため、最新の情報を入手することは不可能です。私たちはあなたがその必要を省くように読書を行います。

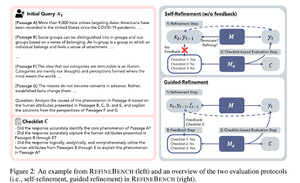

RefineBench:チェックリストによる言語モデルの精緻化能力評価

本論文では、さまざまなシナリオでLMの精錬能力を評価するベンチマークであるRefineBenchを紹介します。自由形式と正確さを重視する作業の両方を組み合わせています。

人文科学、社会科学、法学、STEMの11の分野をカバーしています。これは自己精錬とガイド付き精錬の2つの方法で評価されます。自己精錬の環境では、フロンティアのLMでさえ比較的低いスコアを得ますが、ガイド付き精錬は非常に効果的です。

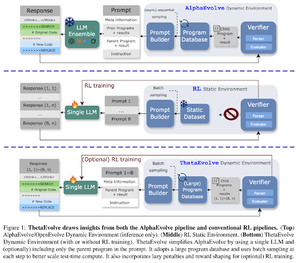

ThetaEvolve:未解決問題に対するテストタイム学習

この論文は、難しい課題に取り組むためのオープンソースパイプラインを提案しています。彼らは、DeepSeek-R1-0528-Qwen3-8B がAlphaEvolveで検討されているいくつかの未解決問題の最もよく知られた境界を改善していることを示しています。

ThetaEvolve上の強化学習は、2つのOSSモデルと4つの難易度問題で推論のみの実行を上回ります。彼らは、モデルが非自明な能力を獲得し、より良いスコアとより速い進行によって証明されることを示しました。この改善は他の作業にも応用できます。

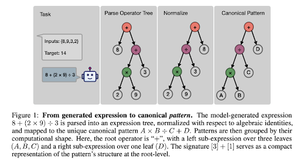

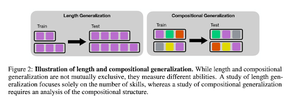

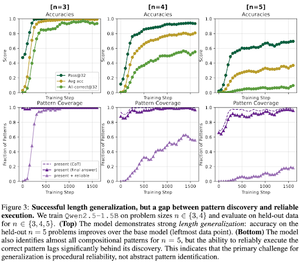

強化学習後のトレーニングはどのようにしてスキル構成を促すのか?カウントダウンに関するケーススタディ

論文では、強化学習がカウントダウンの助けを借りてモデルがスキルを作曲するのを学ぶのにどのように役立つかを探ります。彼らは長さと組成の一般化を解きほぐします。

彼らは以下の通りを見つけました:

1) モデルはより大きなパズルサイズに一般化される

2) パターン構造が難易度を決定する

3) モデルは見えないパターンに一般化します

最終的に、強化学習のポストトレーニングが長さの一般化や部分的な組成の一般化に役立つことを示すことが示されます

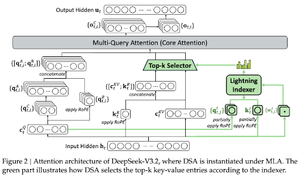

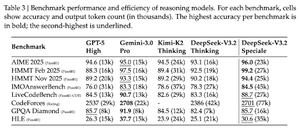

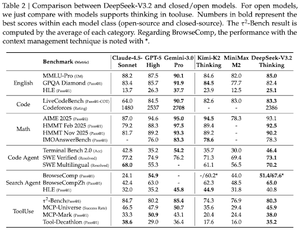

DeepSeek-v3.2:オープン大規模言語モデルの最前線を押し広げる

論文ではDS-V3.2を紹介し、Deepseekのスパースアテンシャルアピールを取り入れ、計算複雑さを低減しつつ長時間のコンテキストシナリオでの性能を維持しています。

強化学習のポストトレーニングでは、専門的な蒸留(ドメインごとにエキスパートモデルをデータ抽出して最終チェックポイントを訓練)と混合強化学習(推論、エージェント、人間のアライメントを一段階で統合)を用いています。

彼らはDSmath-V2を使って特殊モデルを訓練し、IMOでゴールドを獲得しています。

暗号通貨 x AI 研究に関するすべての詳細については、@ritualdigest をフォローしてください。

@ritualnet Ritualが構築しているものについて詳しく知りたい。

357

トップ

ランキング

お気に入り