热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

这是本周的仪式研究摘要,一份涵盖LLM世界和加密与AI交集最新动态的通讯。

每周有数百篇论文发表,跟上最新动态几乎是不可能的。我们为您阅读,所以您无需这样做。

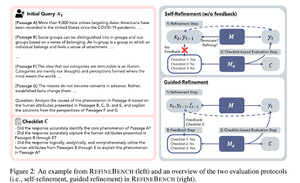

RefineBench:通过检查表评估语言模型的精炼能力

本文介绍了RefineBench,这是一个评估语言模型在各种场景下精炼能力的基准。它结合了自由形式和基于准确性的任务。

它涵盖了人文学科、社会科学、法律和STEM领域的11个领域。这通过两种方式进行评估:自我优化和指导优化。在自我优化的环境中,即使是前沿的语言模型得分也相对较低,而指导优化则非常有效。

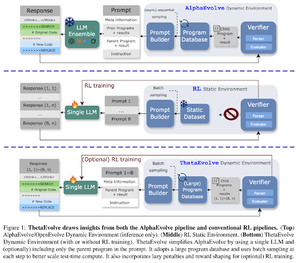

ThetaEvolve:开放问题上的测试时学习

本文提出了一个开源管道,用于解决具有挑战性的问题。他们展示了DeepSeek-R1-0528-Qwen3-8B改善了在AlphaEvolve中考虑的一些开放问题的最佳已知界限。

在ThetaEvolve上,RL的表现优于仅进行推理的运行,涵盖了2个开源模型和4个具有挑战性的问题。他们表明,该模型获得了非平凡的能力,体现在更好的得分和更快的进展上。这一改进甚至可以转移到其他任务上。

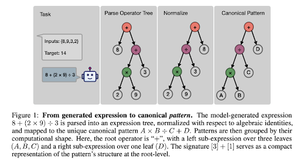

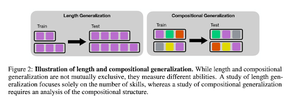

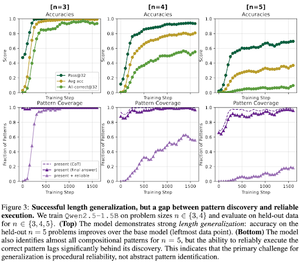

RL后训练如何促进技能组合?以倒计时为例

本文探讨了RL如何帮助模型通过倒计时学习组合技能。他们解开了长度和组合泛化的关系。

他们发现:

1)模型能够推广到更大的难题规模

2)模式结构决定了难度

3)模型能够推广到未见过的模式

最终表明,RL后训练有助于长度推广和部分组合推广

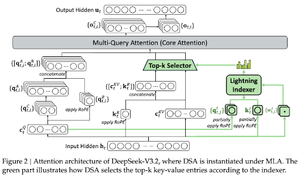

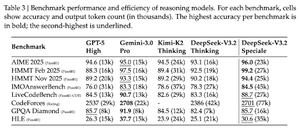

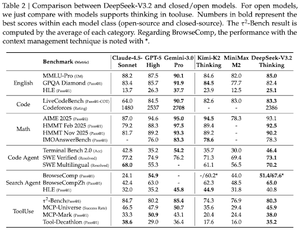

DeepSeek-V3.2:推动开放大型语言模型的前沿

本文介绍了DS-V3.2,它结合了Deepseek稀疏注意力,以降低计算复杂性,同时在长上下文场景中保持性能。

对于RL后训练,他们采用专业蒸馏(根据领域专家模型对数据进行蒸馏以训练最终检查点)和混合RL训练(在一个阶段合并推理、代理和人类对齐)。

他们使用DSmath-V2训练一个特殊模型,在国际数学奥林匹克(IMO)中获得金牌。

关注我们 @ritualdigest,获取更多关于加密货币与 AI 研究的内容,

以及 @ritualnet,了解 Ritual 正在构建的内容。

353

热门

排行

收藏