Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zde je tento týden Ritual Research Digest, zpravodaj pokrývající nejnovější ve světě LLM a průnik Crypto x AI.

Se stovkami novin publikovaných týdně je nemožné mít přehled o těch nejnovějších. Čteme my, takže vy nemusíte.

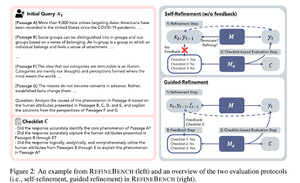

RefineBench: Hodnocení schopností zpřesňování jazykových modelů pomocí kontrolních seznamů

Tento článek představuje RefineBench, benchmark, který hodnotí schopnosti zdokonalování LM v různých scénářích. Zahrnuje jak volné formy, tak úkoly založené na přesnosti.

Zahrnuje 11 oblastí napříč humanitními vědami, společenskými vědami, právem a STEM obory. To se hodnotí dvěma způsoby: sebezdokonalování a řízené zdokonalování. V prostředí samorafinace i frontier LM skórují relativně nízko, zatímco řízené rafinování je velmi efektivní.

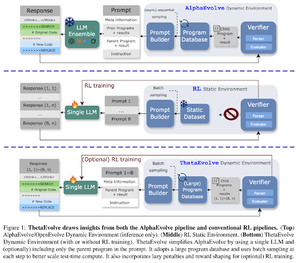

ThetaEvolve: Učení během testů na otevřených problémech

Článek navrhuje opensource pipeline pro řešení náročných problémů. Ukazují, že DeepSeek-R1-0528-Qwen3-8B , zlepšuje nejznámější hranice některých otevřených problémů zvažovaných v AlphaEvolve.

RL na ThetaEvolve překonává pouze inferenční běhy napříč 2 OSS modely a 4 náročnými problémy. Ukazují, že model získává netriviální schopnosti, což dokládají lepší výsledky a rychlejší pokrok. Toto zlepšení se projevuje i v dalších úkolech.

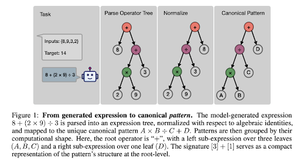

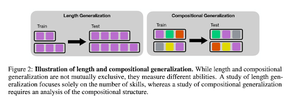

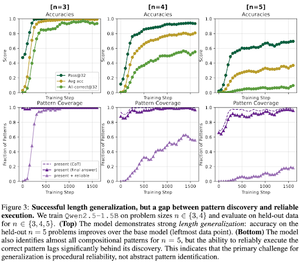

Jak RL po tréninku ovlivňuje složení dovedností? Případová studie o odpočítávání

Článek zkoumá, jak může RL pomoci modelu naučit se skládat dovednosti pomocí odpočítávání. Rozplétají délku a kompoziční zobecnění.

Zjistí, že:

1) Modely se zobecňují na větší velikosti hádanek

2) Struktura vzoru určuje obtížnost

3) Modely zobecňují na neviditelné vzory

Nakonec ukázat, že RL po tréninku pomáhá zobecnění délky a částečné kompoziční generalizaci

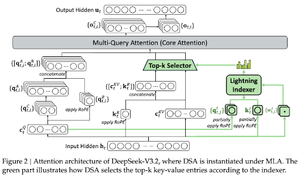

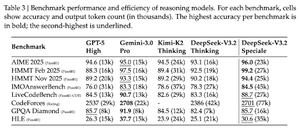

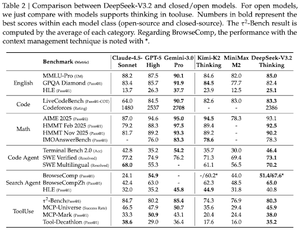

DeepSeek-v3.2: Posouvání hranic otevřených velkých jazykových modelů

Článek představuje DS-V3.2, který využívá Deepseek s úspornou pozorností ke snížení výpočetní složitosti při zachování výkonu v dlouhých kontextových scénářích.

Pro RL posttrénování používají specializovanou destilaci (expertní modely z domény jsou data destilovaná pro trénování finálního kontrolního bodu) a kombinovaný RL trénink (sloučení uvažování, agenta a lidského sladění v jedné fázi).

Trénují speciální model pomocí DSmath-V2, kde podle mého názoru dosahují zlata.

Sledujte nás @ritualdigest pro více informací o všem, co se týká výzkumu crypto x AI, a

@ritualnet se dozvědět více o tom, co Ritual buduje.

352

Top

Hodnocení

Oblíbené