Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Iată Ritual Research Digest din această săptămână, un buletin informativ care acoperă cele mai recente noutăți din lumea LLM-urilor și intersecția dintre Crypto x AI.

Cu sute de lucrări publicate săptămânal, este imposibil să rămânem la curent cu cele mai recente. Noi citim ca să nu trebuiască să o faceți.

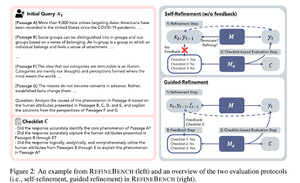

RefineBench: Evaluarea capacității de rafinare a modelelor lingvistice prin liste de verificare

Această lucrare introduce RefineBench, un benchmark care evaluează capacitățile de rafinare ale LM-urilor în diverse scenarii. Include atât sarcini libere, cât și bazate pe acuratețe.

Acoperă 11 domenii din domeniile umaniste, științe sociale, drept și STEM. Acest lucru este evaluat în două moduri: auto-rafinare și rafinare ghidată. Într-un context de autorafinare, chiar și LM-ii frontier obțin un scor relativ scăzut, în timp ce rafinarea ghidată este foarte eficientă.

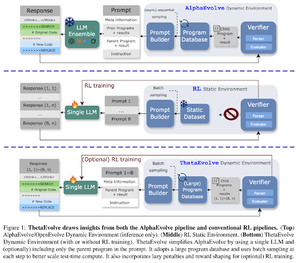

ThetaEvolve: Învățare în timpul testului pe probleme deschise

Lucrarea propune un pipeline open-source pentru abordarea problemelor dificile. Ei arată că DeepSeek-R1-0528-Qwen3-8B , îmbunătățește cele mai cunoscute limite ale unor probleme deschise luate în considerare în AlphaEvolve.

RL pe ThetaEvolve depășește rulările doar prin inferență pe 2 modele OSS și 4 probleme dificile. Ei arată că modelul capătă capabilități netriviale, evidențiate de scoruri mai bune și progres mai rapid. Această îmbunătățire se transferă chiar și la alte sarcini.

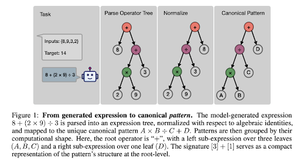

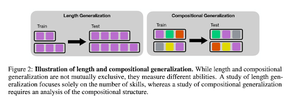

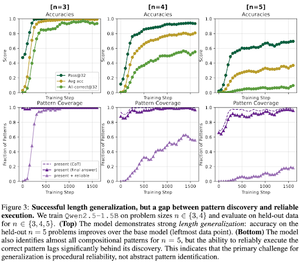

Cum induce perioada de antrenament în viața reală după antrenament compoziția abilităților? Un studiu de caz despre Countdown

Lucrarea explorează cum RL poate ajuta un model să învețe abilități de compoziție cu ajutorul numărătoarei inverse. Ele descurcă lungimea și generalizarea compozițională.

Ei constată că:

1) Modelele se generalizează la dimensiuni mai mari de puzzle-uri

2) Structura tiparului determină dificultatea

3) Modelele se generalizează la tipare nevăzute

În cele din urmă, arătând că RL post-antrenament ajută la generalizarea lungimii și la generalizarea compozițională parțială

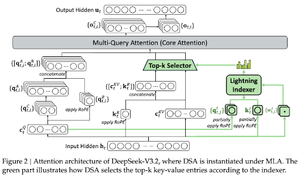

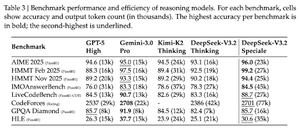

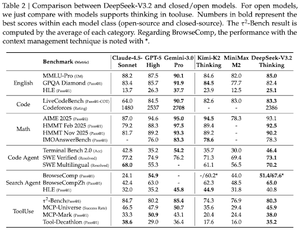

DeepSeek-V3.2: Împingerea frontierei modelelor largi de limbaj deschise

Articolul introduce DS-V3.2, care încorporează atenția redusă Deepseek pentru a reduce complexitatea computațională, păstrând în același timp performanța în scenarii cu context lung.

Pentru posarea RL, ele folosesc distilare specializată (modelele de experți pe domeniu sunt date distilate pentru a antrena punctul final de control) și antrenament RL mixt (raționamentul fuzionat, agentul și alinierea umană într-o singură etapă).

Ei antrenează un model special folosind DSmath-V2, obținând aur la IMO.

Urmăriți-ne @ritualdigest pentru mai multe despre toate lucrurile legate de cercetarea crypto x AI și

@ritualnet să aflați mai multe despre ce construiește Ritual.

371

Limită superioară

Clasament

Favorite