Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Ritual Research Digest desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção de Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com as últimas novidades. Nós fazemos a leitura para que você não precise.

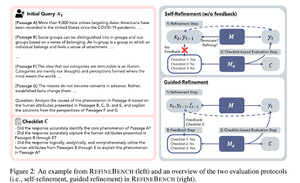

RefineBench: Avaliando a Capacidade de Refinamento dos Modelos de Linguagem por Meio de Listas de Verificação

Este artigo apresenta o RefineBench, um benchmark que avalia as capacidades de refinamento dos LMs em vários cenários. Ele incorpora tarefas tanto livres quanto baseadas em precisão.

Ela abrange 11 áreas nas áreas de humanidades, ciências sociais, direito e áreas STEM. Isso é avaliado de duas maneiras: autorefinamento e refinamento guiado. Em um ambiente de auto-refinamento, mesmo os LMs de fronteira têm uma pontuação relativamente baixa, enquanto o refinamento guiado é muito eficaz.

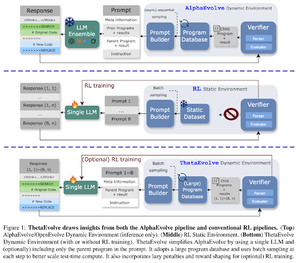

ThetaEvolve: Aprendizado em Tempo de Teste sobre Problemas Abertos

O artigo propõe um pipeline de código aberto para enfrentar problemas desafiadores. Eles mostram que o DeepSeek-R1-0528-Qwen3-8B , melhora os limites mais conhecidos de alguns problemas em aberto considerados no AlphaEvolve.

O RL no ThetaEvolve supera execuções apenas de inferência em 2 modelos OSS e 4 problemas desafiadores. Eles mostram que o modelo ganha capacidades não triviais, como evidenciado por melhores pontuações e progresso mais rápido. Essa melhoria até se transfere para outras tarefas.

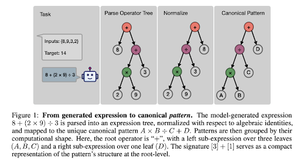

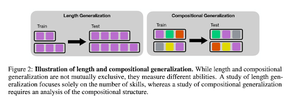

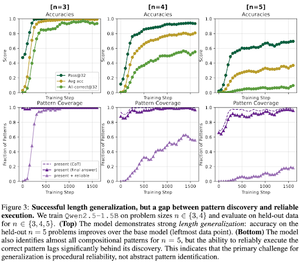

Como o Pós-Treinamento em Vida Real Induz a Composição de Habilidades? Um Estudo de Caso sobre a Contagem Regressiva

O artigo explora como o RL pode ajudar um modelo a aprender habilidades de composição com a ajuda da contagem regressiva. Eles separam o comprimento da generalização composicional.

Eles descobrem que:

1) Modelos generalizam para quebra-cabeças maiores

2) A estrutura do padrão determina a dificuldade

3) Modelos generalizam para padrões invisíveis

Mostrando em última análise que o RL pós-treinamento ajuda na generalização do comprimento e na generalização composicional parcial

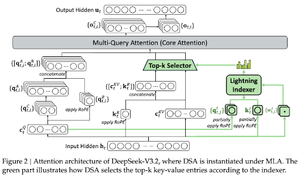

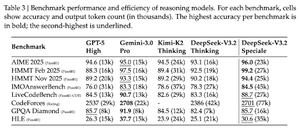

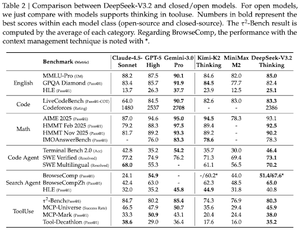

DeepSeek-V3.2: Explorando a Fronteira dos Grandes Modelos de Linguagem Abertos

O artigo apresenta o DS-V3.2, que incorpora atenção esparsa do Deepseek para reduzir a complexidade computacional enquanto preserva o desempenho em cenários de longo prazo.

Para o postraining RL, eles utilizam destilação especializada (por domínio, modelos especialistas são dados destilados para treinar o checkpoint final) e treinamento misto de RL (fusão de raciocínio, agente e alinhamento humano em uma única etapa).

Eles treinam um modelo especial usando DSmath-V2, alcançando ouro na minha opinião.

Siga-nos @ritualdigest para saber mais sobre todas as pesquisas sobre criptomoedas x IA e

@ritualnet para saber mais sobre o que a Ritual está construindo.

365

Melhores

Classificação

Favoritos