Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Berikut adalah Ritual Research Digest minggu ini, buletin yang mencakup yang terbaru di dunia LLM dan persimpangan Crypto x AI.

Dengan ratusan makalah yang diterbitkan setiap minggu, tidak mungkin mengikuti perkembangan terbaru. Kami melakukan pembacaan sehingga Anda tidak perlu melakukannya.

RefineBench: Mengevaluasi Kemampuan Penyempurnaan Model Bahasa melalui Daftar Periksa

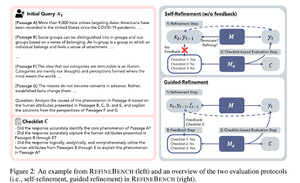

Makalah ini memperkenalkan RefineBench, tolok ukur yang mengevaluasi kemampuan penyempurnaan LM dalam berbagai skenario. Ini menggabungkan tugas bentuk bebas dan berbasis akurasi.

Ini mencakup 11 domain di seluruh bidang humaniora, ilmu sosial, hukum, dan domain STEM. Ini dievaluasi dalam 2 cara: penyempurnaan diri dan penyempurnaan terpandu. Dalam pengaturan penyempurnaan diri, bahkan LM perbatasan pun mendapat skor relatif rendah, sementara penyempurnaan terpandu sangat efektif.

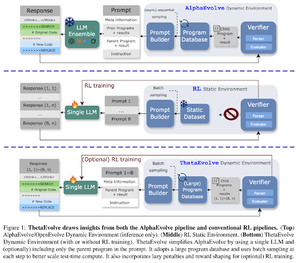

ThetaEvolve: Pembelajaran Waktu Tes tentang Masalah Terbuka

Makalah ini mengusulkan saluran sumber terbuka untuk mengatasi masalah yang menantang. Mereka menunjukkan bahwa DeepSeek-R1-0528-Qwen3-8B , meningkatkan batas yang paling terkenal dari beberapa masalah terbuka yang dipertimbangkan di AlphaEvolve.

RL di ThetaEvolve mengungguli ekspertensi saja di 2 model OSS dan 4 masalah yang menantang. Mereka menunjukkan bahwa model memperoleh kemampuan yang tidak sepele, sebagaimana dibuktikan dengan skor yang lebih baik dan kemajuan yang lebih cepat. Peningkatan ini bahkan ditransfer ke tugas lain.

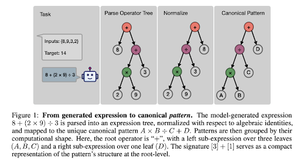

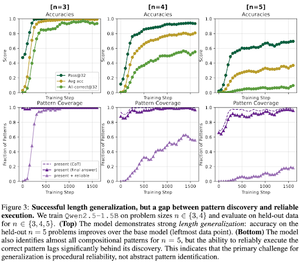

Bagaimana RL Pasca-pelatihan Menginduksi Komposisi Keterampilan? Studi Kasus tentang Hitung Mundur

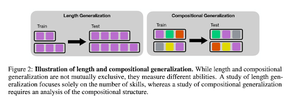

Makalah ini mengeksplorasi bagaimana RL dapat membantu model belajar menyusun keterampilan dengan bantuan hitung mundur. Mereka memisahkan panjang dan generalisasi komposisi.

Mereka menemukan bahwa:

1) Model menggeneralisasi ke ukuran teka-teki yang lebih besar

2) Struktur pola menentukan kesulitan

3) Model menggeneralisasi ke pola yang tidak terlihat

Pada akhirnya menunjukkan bahwa RL pasca-pelatihan membantu generalisasi panjang dan generalisasi komposisi parsial

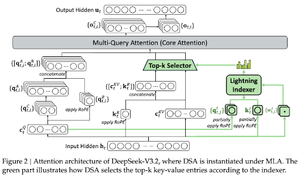

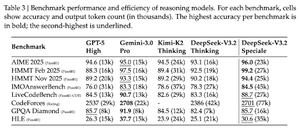

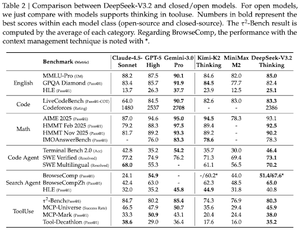

DeepSeek-V3.2: Mendorong Perbatasan Model Bahasa Besar Terbuka

Makalah ini memperkenalkan DS-V3.2, yang menggabungkan perhatian Deepseek yang jarang untuk mengurangi kompleksitas komputasi sambil mempertahankan kinerja dalam skenario konteks panjang.

Untuk postraining RL, mereka menggunakan distilasi spesialis (model ahli per domain disuling data untuk melatih pos pemeriksaan akhir) dan pelatihan RL campuran (menggabungkan penalaran, agen, dan penyelarasan manusia dalam satu tahap).

Mereka melatih model khusus menggunakan DSmath-V2, meraih emas di IMO.

Ikuti kami @ritualdigest untuk informasi lebih lanjut tentang semua hal tentang penelitian crypto x AI, dan

@ritualnet untuk mempelajari lebih lanjut tentang apa yang dibangun Ritual.

354

Teratas

Peringkat

Favorit