Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Voici le Digest de Recherche Rituel de cette semaine, une newsletter couvrant les dernières nouvelles dans le monde des LLM et l'intersection entre Crypto et AI.

Avec des centaines d'articles publiés chaque semaine, il est impossible de rester à jour avec les dernières informations. Nous faisons la lecture pour que vous n'ayez pas à le faire.

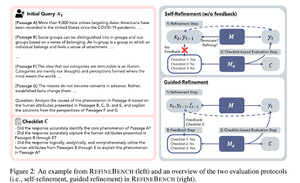

RefineBench : Évaluation de la capacité de raffinement des modèles de langage via des listes de contrôle

Cet article présente RefineBench, un benchmark qui évalue les capacités de raffinement des modèles de langage dans divers scénarios. Il intègre à la fois des tâches en libre format et des tâches basées sur la précision.

Cela couvre 11 domaines dans les sciences humaines, les sciences sociales, le droit et les domaines STEM. Cela est évalué de 2 manières : auto-affinement et affinement guidé. Dans un cadre d'auto-affinement, même les LMs de pointe obtiennent des scores relativement bas, tandis que l'affinement guidé est très efficace.

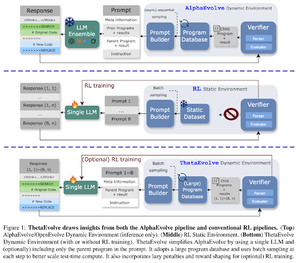

ThetaEvolve : Apprentissage en temps de test sur des problèmes ouverts

L'article propose un pipeline open source pour s'attaquer à des problèmes difficiles. Ils montrent que DeepSeek-R1-0528-Qwen3-8B améliore les meilleures limites connues de certains problèmes ouverts considérés dans AlphaEvolve.

RL sur ThetaEvolve surpasse les exécutions uniquement d'inférence sur 2 modèles OSS et 4 problèmes difficiles. Ils montrent que le modèle acquiert des capacités non triviales, comme en témoignent de meilleurs scores et un progrès plus rapide. Cette amélioration se transfère même à d'autres tâches.

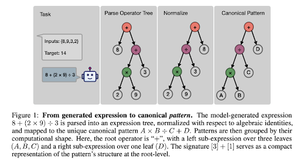

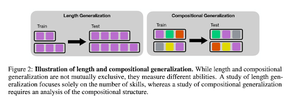

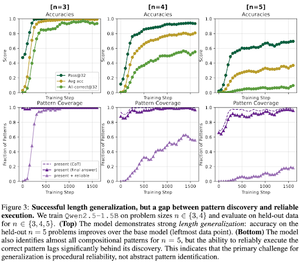

Comment l'apprentissage par renforcement après formation induit-il la composition des compétences ? Une étude de cas sur le compte à rebours

Cet article explore comment l'apprentissage par renforcement peut aider un modèle à apprendre à composer des compétences avec l'aide d'un compte à rebours. Ils démêlent la longueur et la généralisation compositionnelle.

Ils constatent que :

1) Les modèles se généralisent à des tailles de puzzle plus grandes

2) La structure des motifs détermine la difficulté

3) Les modèles se généralisent à des motifs non vus

Démontrant finalement que l'entraînement post-RL aide à la généralisation de la longueur et à la généralisation partielle de la composition.

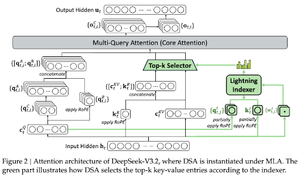

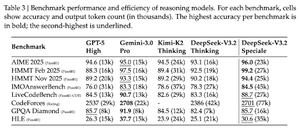

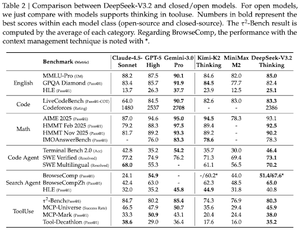

DeepSeek-V3.2 : Pousser la Frontier des Modèles de Langage Ouverts de Grande Taille

L'article présente DS-V3.2, qui intègre l'attention éparse de Deepseek pour réduire la complexité computationnelle tout en préservant les performances dans des scénarios à long contexte.

Pour le post-entraînement RL, ils utilisent la distillation spécialisée (selon les modèles d'experts de domaine, les données sont distillées pour entraîner le point de contrôle final) et l'entraînement RL mixte (fusionner le raisonnement, l'agent et l'alignement humain en une seule étape).

Ils entraînent un modèle spécial en utilisant DSmath-V2, atteignant l'or à l'IMO.

Suivez-nous @ritualdigest pour en savoir plus sur tout ce qui concerne la crypto et la recherche en IA, et @ritualnet pour en apprendre davantage sur ce que Ritual est en train de construire.

364

Meilleurs

Classement

Favoris