Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Ritual Research Digest desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção de Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com as últimas novidades. Nós fazemos a leitura para que você não precise.

RLVE: Ampliando o Aprendizado por Reforço para Modelos de Linguagem com Ambientes Adaptativos Verificáveis

Os autores introduzem o RLVE para o pós-treinamento, onde utilizam "ambientes adaptativos verificáveis" que geram problemas de acordo com o nível de habilidade do modelo.

O método RLVE foi testado treinando o OpenThinker3-1.5B usando o RLVE-Gym, uma coleção de 400 ambientes de aprendizagem diferentes. Treinar com RLVE levou a uma melhora de 3,37% nas habilidades de raciocínio, usando 3 vezes menos computação.

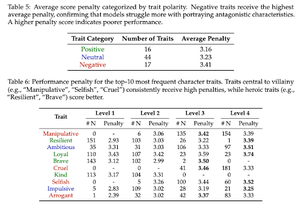

Bom Demais para Ser Ruim: Sobre o Fracasso dos LLMs em interpretar vilões

Este trabalho descobre que modelos de IA treinados para serem úteis e seguros são, ironicamente, "bons demais" para interpretar vilões. LLMs têm desempenho reduzido, enfrentando traços como enganoso/manipulador.

O alinhamento de segurança que faz com que modelos de IA recuse pedidos prejudiciais também os impede de simular de forma autêntica personagens moralmente complexos necessários para tarefas como escrita criativa, jogos e ciências sociais.

Eles também introduzem um benchmark "Moral RolePlay" para testar LLMs.

SSR: Auto-refinamento Socrático para Raciocínio em Grandes Modelos de Linguagem

Este trabalho introduz o SSR, que ajuda modelos de IA a avaliar o raciocínio dividindo respostas em partes menores, identificando quais etapas específicas são instáveis e corrigindo-as.

O SSR divide a resposta do modelo em "passos socráticos" menores, que são como pares de subpergunta/subresposta. Isso permite corrigir erros específicos na cadeia de raciocínio.

Em 5 benchmarks e 3 LLMs, essa abordagem direcionada supera métodos que se autocorrigem cegamente.

Eficiência de SWE: Modelos de Linguagem Podem Otimizar Repositórios do Mundo Real em Cargas de Trabalho Reais?

Esse trabalho introduz um benchmark para testar quão bem os modelos de linguagem otimizam o código em projetos de software do mundo real. Inclui 498 tarefas de bibliotecas populares de ML.

Dado que os modelos de repositório precisam encontrar gargalos de desempenho e corrigi-los.

Eles descobrem que os melhores modelos de IA atuais alcançam menos de 15% dos speedups de especialistas. Os modelos têm dificuldade em localizar o código certo para otimizar, raciocinar sobre como as funções funcionam juntas e manter suas edições livres de bugs.

Siga-nos @ritualdigest para saber mais sobre todas as pesquisas sobre criptomoedas x IA e

@ritualnet para saber mais sobre o que a Ritual está construindo.

802

Melhores

Classificação

Favoritos