Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Digest de Investigación Ritual de esta semana, un boletín que cubre lo último en el mundo de los LLM y la intersección de Crypto x AI.

Con cientos de artículos publicados semanalmente, mantenerse al día con lo último es imposible. Hacemos la lectura para que tú no tengas que hacerlo.

RLVE: Escalando el Aprendizaje por Refuerzo para Modelos de Lenguaje con Entornos Verificables Adaptativos

Los autores presentan RLVE para el post-entrenamiento donde utilizan "entornos verificables adaptativos" que generan problemas de acuerdo con el nivel de habilidad del modelo.

El método RLVE fue probado entrenando OpenThinker3-1.5B utilizando RLVE-Gym, una colección de 400 entornos de aprendizaje diferentes. El entrenamiento con RLVE llevó a una mejora del 3.37% en las habilidades de razonamiento mientras se utilizó 3 veces menos computación.

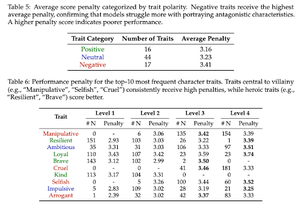

Demasiado bueno para ser malo: sobre el fracaso de los LLMs para interpretar villanos

Este trabajo encuentra que los modelos de IA entrenados para ser útiles y seguros son irónicamente "demasiado buenos" para interpretar villanos. Los LLMs disminuyen en rendimiento, luchando con rasgos como el engañoso/manipulador.

La alineación de seguridad que hace que los modelos de IA rechacen solicitudes dañinas también les impide simular auténticamente personajes moralmente complejos necesarios para tareas como la escritura creativa, los juegos y las ciencias sociales.

También introducen un benchmark de "Moral RolePlay" para probar los LLMs.

SSR: Auto-refinamiento socrático para el razonamiento de modelos de lenguaje grandes

Este trabajo presenta SSR, que ayuda a los modelos de IA a evaluar el razonamiento dividiendo las respuestas en partes más pequeñas, identificando qué pasos específicos son inestables y corrigiéndolos.

SSR descompone la respuesta del modelo en pasos más pequeños "socráticos", que son como pares de sub-pregunta/sub-respuesta. Esto permite corregir errores específicos en la cadena de razonamiento.

A través de 5 benchmarks y 3 LLMs, este enfoque dirigido supera a los métodos que se autocorrigen ciegamente.

SWE-eficiencia: ¿Pueden los Modelos de Lenguaje Optimizar Repositorios del Mundo Real en Cargas de Trabajo Reales?

Este trabajo introduce un benchmark para probar qué tan bien los modelos de lenguaje optimizan el código en proyectos de software del mundo real. Incluye 498 tareas de bibliotecas de ML populares.

Los modelos de repositorios dados deben encontrar cuellos de botella en el rendimiento y solucionarlos.

Descubren que los mejores modelos de IA de hoy logran menos del 15% de las aceleraciones de expertos. Los modelos tienen dificultades para localizar el código correcto para optimizar, razonar sobre cómo funcionan juntos las funciones y mantener sus ediciones libres de errores.

Síguenos en @ritualdigest para más información sobre todo lo relacionado con la investigación en cripto x IA, y

@ritualnet para aprender más sobre lo que Ritual está construyendo.

791

Parte superior

Clasificación

Favoritos