Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tässä on tämän viikon Ritual Research Digest, uutiskirje, joka kattaa viimeisimmät tiedot LLM:ien maailmasta ja Crypto x AI:n risteyskohdasta.

Viikoittain julkaistaan satoja lehtiä, joten on mahdotonta pysyä ajan tasalla uusimmasta uutisesta. Me teemme lukemisen, jotta sinun ei tarvitse.

RLVE: Vahvistusoppimisen laajentaminen kielimalleissa adaptiivisilla todennettavilla ympäristöillä

Kirjoittajat esittelevät RLVE:n jälkikoulutukseen, jossa käytetään "adaptiivisia todennettavia ympäristöjä", jotka tuottavat ongelmia mallin taitotason mukaan.

RLVE-menetelmää testattiin kouluttamalla OpenThinker3-1.5B:tä RLVE-Gymillä, joka on 400 erilaisen oppimisympäristön kokoelma. RLVE-harjoittelu paransi päättelykykyä 3,37 %, kun laskentatehoa käytettiin 3 kertaa vähemmän.

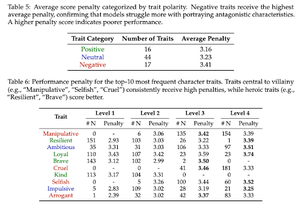

Liian hyvä ollakseen huono: LLM:ien epäonnistumisesta roolipelata pahiksia

Tämä työ osoittaa, että tekoälymallit, jotka on koulutettu olemaan hyödyllisiä ja turvallisia, ovat ironisesti "liian hyviä" roolipelaamaan pahiksia. LLM:t heikkenevät suorituskyvyssään, kamppailevat petollisen ja manipuloivan kaltaisten piirteiden kanssa.

Turvallisuuslinjaus, joka saa tekoälymallit kieltäytymään haitallisista pyynnöistä, estää niitä myös simuloimasta moraalisesti monimutkaisia hahmoja, joita tarvitaan luovassa kirjoittamisessa, peleissä ja yhteiskuntatieteissä.

He ottavat myös käyttöön "Moraalisen roolipelin" testaamaan LLM:iä.

SSR: Sokraattinen itse-hienosäätö suurten kielimallien päättelyyn

Tässä työssä esitellään SSR, joka auttaa tekoälymalleja arvioimaan päättelyä pilkkomalla vastaukset pienempiin osiin, tunnistamalla mitkä vaiheet ovat epävarmoja ja korjaamalla ne.

SSR jakaa mallivastauksen pienempiin "sokraattisiin askeliin", jotka ovat kuin alakysymys/vastaus-pareja. Tämä mahdollistaa tiettyjen virheiden korjaamisen päättelyketjussa.

Viidessä vertailussa ja kolmessa LLM:ssä tämä kohdennettu lähestymistapa päihittää sokeasti itsekorjaavat menetelmät.

SWE-tehokkuus: Voivatko kielimallit optimoida todellisia tietovarastoja oikeilla työkuormilla?

Tämä työ esittelee vertailun, jolla testataan, kuinka hyvin kielimallit optimoivat koodia todellisissa ohjelmistoprojekteissa. Se sisältää 498 tehtävää suosituista koneoppimiskirjastoista.

Tietyt repomallien täytyy löytää suorituskykypullonkaulat ja korjata ne.

He havaitsivat, että tämän päivän parhaat tekoälymallit saavuttavat alle 15 % asiantuntijoiden nopeutuksista. Mallit kamppailevat löytääkseen oikean koodin optimoitavaksi, perustellakseen funktioiden toimintaa yhdessä ja pitääkseen muokkaukset virheettöminä.

Seuraa meitä @ritualdigest saadaksesi lisätietoja kaikesta krypto x AI -tutkimuksesta ja

@ritualnet oppia lisää siitä, mitä Ritual rakentaa.

804

Johtavat

Rankkaus

Suosikit