Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die de laatste ontwikkelingen in de wereld van LLM's en de kruising van Crypto x AI behandelt.

Met honderden gepubliceerde artikelen per week is het onmogelijk om bij te blijven met het laatste nieuws. Wij doen het lezen zodat jij dat niet hoeft te doen.

RLVE: Opschalen van Versterkend Leren voor Taalmodellen met Adaptieve Verifieerbare Omgevingen

De auteurs introduceren RLVE voor post-training waarbij ze "adaptieve verifieerbare omgevingen" gebruiken die problemen genereren op basis van het vaardigheidsniveau van het model.

De RLVE-methode werd getest door OpenThinker3-1.5B te trainen met RLVE-Gym, een verzameling van 400 verschillende leeromgevingen. Training met RLVE leidde tot een verbetering van 3,37% in redeneervaardigheden terwijl er 3x minder rekencapaciteit werd gebruikt.

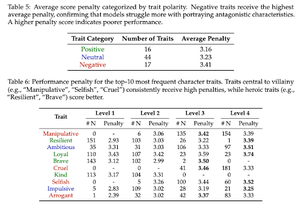

Te goed om slecht te zijn: Over het falen van LLM's om schurken te spelen

Dit werk toont aan dat AI-modellen die zijn getraind om behulpzaam en veilig te zijn, ironisch genoeg "te goed" zijn om schurken te spelen. LLM's nemen in prestaties af en hebben moeite met eigenschappen zoals bedrieglijk/manipulatief.

Veiligheidsafstemming die AI-modellen dwingt om schadelijke verzoeken te weigeren, voorkomt ook dat ze authentiek moreel complexe personages simuleren die nodig zijn voor taken zoals creatief schrijven, games en sociale wetenschappen.

Ze introduceren ook een "Moral RolePlay" benchmark om LLM's te testen.

SSR: Socratic Self-Refine voor Redenering van Grote Taalmodellen

Dit werk introduceert SSR, dat AI-modellen helpt bij het beoordelen van redenering door antwoorden op te splitsen in kleinere stukjes, te identificeren welke specifieke stappen wankel zijn, en deze te corrigeren.

SSR splitst de modelrespons op in kleinere "Socratische stappen," die lijken op sub-vragen/sub-antwoorden paren. Dit maakt het mogelijk om specifieke fouten in de redeneerketen te corrigeren.

Bij 5 benchmarks en 3 LLM's presteert deze gerichte aanpak beter dan methoden die blindelings zelfcorrigeren.

SWE-fficiency: Kunnen taalmodellen echte repositories optimaliseren op echte workloads?

Dit werk introduceert een benchmark om te testen hoe goed taalmodellen code optimaliseren in echte softwareprojecten. Het omvat 498 taken uit populaire ML-bibliotheken.

Gegeven repos-modellen moeten prestatieknelpunten vinden en deze oplossen.

Ze ontdekken dat de beste AI-modellen van vandaag minder dan 15% van de snelheid van experts bereiken. De modellen hebben moeite om de juiste code te vinden om te optimaliseren, om te redeneren over hoe functies samenwerken, en om hun aanpassingen bug-vrij te houden.

Volg ons @ritualdigest voor meer over alles wat met crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

793

Boven

Positie

Favorieten