Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek knäckte O(L²)-uppmärksamhetsflaskhalsen.

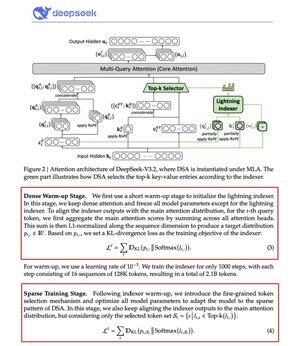

Deras nya V3.2-modell introducerar DeepSeek Sparse Attention (DSA), och det är den enda arkitektoniska förändringen de gjorde. Det visar hur viktigt detta är.

Vad löser det:

Standarduppmärksamhet skalar kvadratikskt. Dubbla din kontextlängd, fyrdubbla beräkningen. Det är därför långkontextinferens snabbt blir dyrt.

DSA sänker komplexiteten från O(L²) till O(Lk), där k är fast.

Så här fungerar det:

En lättviktig Lightning Indexer bedömer vilka tokens som faktiskt är viktiga för varje fråga. Litet antal huvuden, körs i FP8, beräkningsmässigt billigt. Därefter hämtar en urvalsmekanism endast de högsta k nyckelvärdesposterna.

Den viktigaste insikten: endast 2 048 tokens väljs per fråga, oavsett kontextlängd. Den dyra uppmärksamhetsberäkningen sker på denna lilla delmängd, inte på hela 128K-sekvensen.

Mindre uppmärksamhet, bättre resultat. DeepSeek V3.2 bevisade det precis.

Resultaten:

Vid 128K kontext sjunker förfyllningskostnaderna från ~0,65 dollar till ~0,35 dollar per miljon tokens. Avkodningen sjunker från ~2,4 till ~0,8 dollar.

Och prestanda? Det förblir detsamma. På vissa långkontext-benchmarks får V3.2 faktiskt högre poäng.

Gles uppmärksamhet är inget nytt. Att få det att fungera utan att tappa kvalitet är svårt.

DeepSeek knäckte den med en tvåstegs träningsprocess, först genom att justera indexeraren med hjälp av KL-divergens, sedan träna hela modellen för att anpassa sig till glesa mönster.

Så här skalar du kontext utan att skala kostnaderna.

...

Topp

Rankning

Favoriter