Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

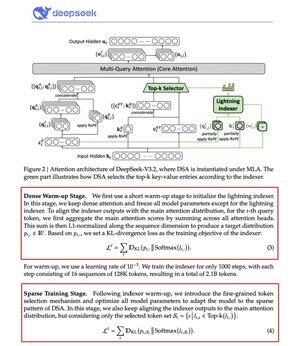

DeepSeek hat den O(L²) Aufmerksamkeitsengpass geknackt.

Ihr neues V3.2-Modell führt die DeepSeek Sparse Attention (DSA) ein, und das ist die einzige architektonische Änderung, die sie vorgenommen haben. Das zeigt, wie wichtig das ist.

Was löst es:

Standardaufmerksamkeit skaliert quadratisch. Verdoppeln Sie Ihre Kontextlänge, vervierfachen Sie die Berechnungen. Deshalb wird die Inferenz mit langem Kontext schnell teuer.

DSA senkt die Komplexität von O(L²) auf O(Lk), wobei k fest ist.

Wie es funktioniert:

Ein leichtgewichtiger Lightning Indexer bewertet, welche Tokens für jede Abfrage tatsächlich wichtig sind. Eine kleine Anzahl von Köpfen, läuft in FP8, rechnerisch günstig. Dann ruft ein Auswahlmechanismus nur die Top-k Schlüssel-Wert-Einträge ab.

Die zentrale Erkenntnis: Nur 2.048 Tokens werden pro Abfrage ausgewählt, unabhängig von der Kontextlänge. Die teure Aufmerksamkeitsberechnung erfolgt auf diesem kleinen Teilset, nicht auf der gesamten 128K-Sequenz.

Weniger Aufmerksamkeit, bessere Ergebnisse. DeepSeek V3.2 hat es gerade bewiesen.

Die Ergebnisse:

Bei 128K Kontext sinken die Vorabfüllkosten von ~$0.65 auf ~$0.35 pro Million Tokens. Das Decoding sinkt von ~$2.4 auf ~$0.8.

Und die Leistung? Bleibt gleich. Bei einigen Benchmarks mit langem Kontext erzielt V3.2 tatsächlich höhere Werte.

Sparse Attention ist nicht neu. Es ist schwierig, es zum Laufen zu bringen, ohne die Qualität zu verlieren.

DeepSeek hat es mit einem zweistufigen Trainingsprozess geschafft, zuerst den Indexer mit KL-Divergenz auszurichten und dann das vollständige Modell zu trainieren, um sich an spärliche Muster anzupassen.

So skalieren Sie den Kontext, ohne die Kosten zu steigern.

...

Top

Ranking

Favoriten