Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek ha superado el cuello de botella de atención O(L²).

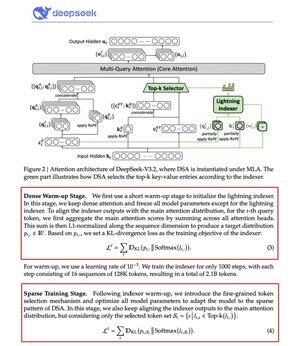

Su nuevo modelo V3.2 introduce la Atención Dispersa de DeepSeek (DSA), y es el único cambio arquitectónico que hicieron. Eso te dice lo importante que es esto.

¿Qué resuelve?

La atención estándar escala cuadráticamente. Duplicas la longitud de tu contexto, cuadruplicas el cómputo. Por eso la inferencia de largo contexto se vuelve costosa rápidamente.

DSA reduce la complejidad de O(L²) a O(Lk), donde k es fijo.

¿Cómo funciona?

Un indexador ligero de Lightning puntúa qué tokens realmente importan para cada consulta. Un pequeño número de cabezas, funciona en FP8, computacionalmente barato. Luego, un mecanismo de selección recupera solo las entradas clave-valor top-k.

La clave: solo se seleccionan 2,048 tokens por consulta, independientemente de la longitud del contexto. El costoso cálculo de atención ocurre en este pequeño subconjunto, no en la secuencia completa de 128K.

Menos atención, mejores resultados. DeepSeek V3.2 acaba de demostrarlo.

Los resultados:

Con un contexto de 128K, los costos de prellenado caen de ~$0.65 a ~$0.35 por millón de tokens. La decodificación cae de ~$2.4 a ~$0.8.

¿Y el rendimiento? Se mantiene igual. En algunas pruebas de largo contexto, V3.2 en realidad obtiene una puntuación más alta.

La atención dispersa no es nueva. Hacer que funcione sin perder calidad es difícil.

DeepSeek lo logró con un proceso de entrenamiento en dos etapas, primero alineando el indexador usando divergencia KL, luego entrenando el modelo completo para adaptarse a patrones dispersos.

Así es como escalas el contexto sin escalar costos.

...

Parte superior

Clasificación

Favoritos