Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek løste O(L²)-oppmerksomhetsflaskehalsen.

Deres nye V3.2-modell introduserer DeepSeek Sparse Attention (DSA), og det er den eneste arkitektoniske endringen de har gjort. Det sier hvor viktig dette er.

Hva løser det:

Standard oppmerksomhet skalerer kvadratiksk. Dobler kontekstlengden din, firedobl beregningen. Dette er grunnen til at lang-kontekst-inferens blir dyrt raskt.

DSA senker kompleksiteten fra O(L²) til O(Lk), hvor k er fast.

Slik fungerer det:

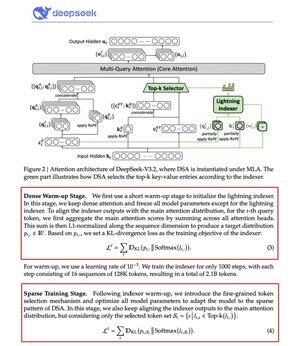

En lettvekts Lightning Indexer vurderer hvilke tokens som faktisk betyr noe for hver spørring. Lite antall hode, kjører i FP8, beregningsmessig billig. Deretter henter en seleksjonsmekanisme kun de øverste k nøkkelverdioppføringene.

Den viktigste innsikten: kun 2 048 tokens blir valgt per spørring, uavhengig av kontekstlengde. Den kostbare oppmerksomhetsberegningen skjer på dette lille delsettet, ikke på hele 128K-sekvensen.

Mindre oppmerksomhet, bedre resultater. DeepSeek V3.2 beviste nettopp det.

Resultatene:

Ved 128K-kontekst faller forhåndsfyllingskostnadene fra ~0,65 til ~0,35 dollar per million tokens. Dekodingen faller fra ~$2,4 til ~$0,8.

Og prestasjon? Det forblir det samme. På noen langtidskontekst-benchmarks scorer V3.2 faktisk høyere.

Sparsom oppmerksomhet er ikke noe nytt. Å få det til å fungere uten å miste kvalitet er vanskelig.

DeepSeek løste dette med en totrinns treningsprosess, først ved å justere indekseren ved hjelp av KL-divergens, deretter ved å trene hele modellen for å tilpasse seg sparsomme mønstre.

Slik skalerer du kontekst uten å skalere kostnadene.

...

Topp

Rangering

Favoritter