Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek зламав вузьке місце уваги O(L²).

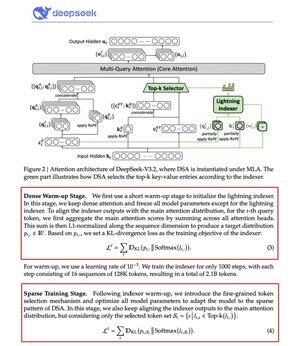

Їхня нова модель V3.2 вводить DeepSeek Sparse Attention (DSA), і це єдина архітектурна зміна, яку вони внесли. Це показує, наскільки це важливо.

Що вона вирішує:

Стандартна увага масштабується квадратично. Подвоїть довжину контексту, збільшуйте обчислення в чотири рази. Ось чому довгоконтекстні висновки швидко стають дорогими.

DSA знижує складність з O(L²) до O(Lk), де k фіксовано.

Як це працює:

Легкий Lightning Indexer оцінює, які токени дійсно важливі для кожного запиту. Невелика кількість головок, працює у FP8, обчислювально дешево. Тоді механізм вибору отримує лише верхні k записів значення ключа.

Головний висновок: на кожен запит вибирається лише 2 048 токенів, незалежно від довжини контексту. Дорогі обчислення уваги відбуваються на цій невеликій підмножині, а не на повній послідовності 128K.

Менше уваги — кращі результати. DeepSeek V3.2 щойно це довела.

Результати:

При контексті 128K вартість попереднього заповнення знижується з ~$0.65 до ~$0.35 за мільйон токенів. Декодування падає з ~$2.4 до ~$0.8.

А продуктивність? Залишається незмінним. У деяких довгоконтекстних бенчмарках V3.2 насправді отримує вищі бали.

Обмежена увага — не новина. Зробити так, щоб це працювало, не втрачаючи якість, важко.

DeepSeek вирішив це за допомогою двоетапного навчального процесу: спочатку вирівнював індексатор за допомогою KL-дивергенції, а потім навчав повну модель адаптуватися до розріджених патернів.

Ось так масштабуєш контекст без масштабування витрат.

...

Найкращі

Рейтинг

Вибране