Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek ha risolto il collo di bottiglia dell'attenzione O(L²).

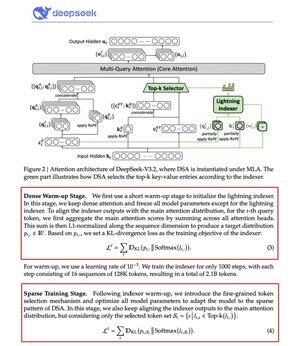

Il loro nuovo modello V3.2 introduce l'attenzione sparsa DeepSeek (DSA), ed è l'unica modifica architettonica che hanno fatto. Questo ti dice quanto sia importante.

Cosa risolve:

L'attenzione standard scala quadraticamente. Raddoppia la lunghezza del contesto, quadruplica il calcolo. Questo è il motivo per cui l'inferenza a lungo contesto diventa costosa rapidamente.

DSA riduce la complessità da O(L²) a O(Lk), dove k è fisso.

Come funziona:

Un indicizzatore Lightning leggero valuta quali token sono realmente importanti per ogni query. Un numero ridotto di teste, funziona in FP8, computazionalmente economico. Poi un meccanismo di selezione recupera solo le prime k voci chiave-valore.

L'intuizione chiave: solo 2.048 token vengono selezionati per query, indipendentemente dalla lunghezza del contesto. Il costoso calcolo dell'attenzione avviene su questo piccolo sottoinsieme, non sull'intera sequenza di 128K.

Meno attenzione, migliori risultati. DeepSeek V3.2 lo ha appena dimostrato.

I risultati:

A 128K di contesto, i costi di precompilazione scendono da ~$0.65 a ~$0.35 per milione di token. La decodifica scende da ~$2.4 a ~$0.8.

E le prestazioni? Rimangono le stesse. Su alcuni benchmark a lungo contesto, V3.2 ottiene effettivamente punteggi più alti.

L'attenzione sparsa non è nuova. Farla funzionare senza perdere qualità è difficile.

DeepSeek l'ha risolta con un processo di addestramento in due fasi, prima allineando l'indicizzatore usando la divergenza KL, poi addestrando il modello completo per adattarsi ai modelli sparsi.

Questo è come scalare il contesto senza aumentare i costi.

...

Principali

Ranking

Preferiti