Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

O DeepSeek resolveu o gargalo de atenção O(L²).

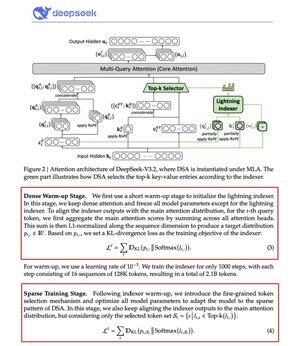

O novo modelo V3.2 introduz o DeepSeek Sparse Attention (DSA), e essa é a única mudança arquitetônica que eles fizeram. Isso mostra o quanto isso é importante.

O que isso resolve:

A atenção padrão escala quadráticamente. Dobre o comprimento do seu contexto, quadruplica o cálculo. É por isso que a inferência em contexto longo se torna cara rapidamente.

DSA reduz a complexidade de O(L²) para O(Lk), onde k é fixo.

Como funciona:

Um Lightning Indexer leve pontua quais tokens realmente importam para cada consulta. Pequeno número de cabeças, roda em FP8, computacionalmente barato. Depois, um mecanismo de seleção recupera apenas as k entradas-chave-valor top.

O insight principal: apenas 2.048 tokens são selecionados por consulta, independentemente do comprimento do contexto. O cálculo de atenção caro acontece nesse pequeno subconjunto, não na sequência completa de 128K.

Menos atenção, melhores resultados. O DeepSeek V3.2 acabou de provar isso.

Os resultados:

No contexto de 128K, os custos de preenchimento caem de ~$0,65 para ~$0,35 por milhão de tokens. A decodificação cai de ~$2,4 para ~$0,8.

E o desempenho? Permanece igual. Em alguns benchmarks de contexto longo, a V3.2 na verdade tem pontuações mais altas.

Atenção escassa não é novidade. Fazer funcionar sem perder qualidade é difícil.

A DeepSeek resolveu isso com um processo de treinamento em duas etapas, primeiro alinhando o indexador usando divergência KL, depois treinando o modelo completo para se adaptar a padrões esparsos.

É assim que você escala o contexto sem escalar custos.

...

Melhores

Classificação

Favoritos