Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek преодолел узкое место O(L²) в механизме внимания.

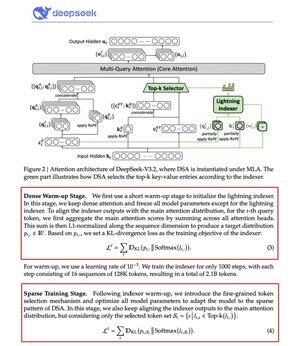

Их новая модель V3.2 вводит DeepSeek Sparse Attention (DSA), и это единственное архитектурное изменение, которое они сделали. Это говорит о том, насколько это важно.

Что это решает:

Стандартное внимание масштабируется квадратично. Удвоите длину контекста — учет вычислений увеличивается в четыре раза. Вот почему вывод с длинным контекстом быстро становится дорогим.

DSA снижает сложность с O(L²) до O(Lk), где k фиксировано.

Как это работает:

Легкий Lightning Indexer оценивает, какие токены действительно важны для каждого запроса. Небольшое количество голов, работает в FP8, вычислительно дешево. Затем механизм выбора извлекает только топ-k ключевых значений.

Ключевое понимание: только 2,048 токенов выбираются на запрос, независимо от длины контекста. Дорогая вычислительная работа по вниманию происходит на этом небольшом подмножестве, а не на всей последовательности в 128K.

Меньше внимания — лучшие результаты. DeepSeek V3.2 только что это доказал.

Результаты:

При 128K контексте затраты на предварительное заполнение снижаются с ~$0.65 до ~$0.35 за миллион токенов. Декодирование снижается с ~$2.4 до ~$0.8.

А производительность? Остается такой же. На некоторых тестах с длинным контекстом V3.2 на самом деле показывает более высокие результаты.

Разреженное внимание не ново. Сделать его работающим без потери качества сложно.

DeepSeek справился с этим с помощью двухступенчатого процесса обучения, сначала выравнивая индексатор с использованием KL-дивергенции, а затем обучая полную модель адаптироваться к разреженным паттернам.

Вот как вы масштабируете контекст, не увеличивая затраты.

...

Топ

Рейтинг

Избранное