المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

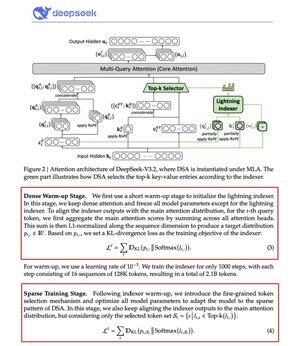

ديب سيك كسر عنق الزجاجة في الانتباه من O(L²).

يقدم نموذج V3.2 الجديد الخاص بهم نظام DeepSeek Sparse Attention (DSA)، وهو التغيير المعماري الوحيد الذي أجروه. هذا يوضح مدى أهمية هذا.

ما الذي يحله:

الانتباه القياسي يتناسب بشكل تربيعي. ضاعف طول السياق، وضاعف الحساب أربع مرات. لهذا السبب يصبح الاستدلال في السياق الطويل مكلفا بسرعة.

DSA يخفض التعقيد من O(L²) إلى O(Lk)، حيث k ثابت.

كيف يعمل:

مؤشر Lightning Indexer خفيف الوزن يحدد أي الرموز مهمة فعلا لكل استفسار. عدد قليل من الرؤوس، يعمل في FP8، ورخيص حسابيا. ثم تقوم آلية الاختيار باسترجاع فقط مدخلات قيمة المفتاح الأعلى-k.

النقطة الأساسية: يتم اختيار 2,048 رمزا فقط لكل استفسار، بغض النظر عن طول السياق. الحساب المكلف للانتباه يحدث على هذه المجموعة الصغيرة، وليس على تسلسل 128K الكامل.

انتباه أقل، ونتائج أفضل. DeepSeek V3.2 أثبت ذلك للتو.

النتائج:

عند سياق 128 ألف، تنخفض تكاليف التعبئة المسبق من ~$0.65 إلى ~$0.35 لكل مليون رمز. ينخفض فك التشفير من ~$2.4 إلى ~$0.8.

والأداء؟ يبقى كما هو. في بعض معايير السياق الطويل، يحصل V3.2 على درجات أعلى فعليا.

الاهتمام المحدود ليس جديدا. جعلها تعمل دون فقدان الجودة أمر صعب.

تمكنت DeepSeek من حل ذلك بعملية تدريب من مرحلتين، حيث تم أولا محاذاة الفهرس باستخدام تباعد KL، ثم تدريب النموذج الكامل على التكيف مع الأنماط المتفرقة.

هذه هي الطريقة التي تتوسع بها السياق دون الحاجة إلى زيادة التكاليف.

...

الأفضل

المُتصدِّرة

التطبيقات المفضلة