Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek ratkaisi O(L²):n huomion pullonkaulan.

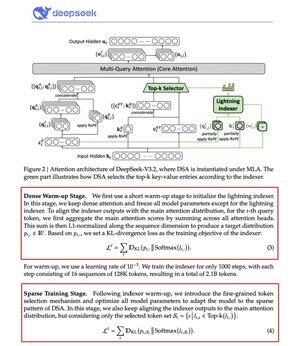

Heidän uusi V3.2-mallinsa esittelee DeepSeek Sparse Attention (DSA) -mallin, ja se on ainoa arkkitehtoninen muutos, jonka he tekivät. Se kertoo, kuinka tärkeää tämä on.

Mitä se ratkaisee:

Tavallinen tarkkaavaisuus skaalautuu neliömäisesti. Kaksinkertaista kontekstin pituus, nelinkertaista laskenta. Tästä syystä pitkän kontekstin päättely käy nopeasti kalliiksi.

DSA laskee monimutkaisuuden O(L²):stä O(Lk):hen, missä k on kiinteä.

Miten se toimii:

Kevyt Lightning Indexer arvioi, mitkä tokenit oikeasti merkitsevät kussakin kyselyssä. Pieni määrä päitä, pyörii FP8:ssa, laskennallisesti halpaa. Tällöin valintamekanismi hakee vain top-k avainarvomerkinnät.

Keskeinen oivallus: vain 2 048 tokenia valitaan per kysely, riippumatta kontekstin pituudesta. Kallis tarkkaavaisuuslaskenta tapahtuu tällä pienellä osajoukolla, ei koko 128K-sarjalla.

Vähemmän huomiota, parempia tuloksia. DeepSeek V3.2 todisti sen juuri.

Tulokset:

128 000 kontekstissa esitäyttökulut laskevat ~0,65 dollarista ~0,35 dollariin miljoonaa tokenia kohden. Dekoodaus putoaa ~$2,4:stä ~$0,8:aan.

Entä suorituskyky? Pysyy samana. Joissain pitkän kontekstin testeissä V3.2 saa itse asiassa korkeammat pisteet.

Vähäinen huomio ei ole uutta. Sen saaminen toimimaan ilman laadun menetystä on vaikeaa.

DeepSeek ratkaisi sen kaksivaiheisella koulutusprosessilla, ensin kohdistamalla indeksaattorin KL-divergenssin avulla ja sitten kouluttaen koko mallin sopeutumaan harvinaisempiin kuvioihin.

Näin skaalaat kontekstin ilman kustannusten skaalausta.

...

Johtavat

Rankkaus

Suosikit