トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeekはO(L²)の注意のボトルネックを突破しました。

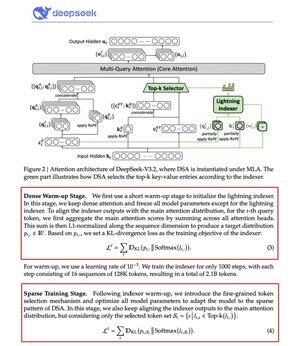

新しいV3.2モデルではDeepSeek Sparse Attention(DSA)が導入されており、これが唯一のアーキテクチャ変更です。それがどれほど重要かを物語っています。

何が解決するのか:

標準的な注意は2乗スケールです。コンテキストの長さを2倍にし、計算量を4倍にします。これがロングコンテキスト推論が急速にコストがかかる理由です。

DSAは複雑度をO(L²)からO(Lk)に下げ、kが固定されます。

仕組み:

軽量のライトニングインデクサーは、各クエリで実際に重要なトークンを評価します。ヘッド数は少なく、FP8で動作し、計算コストも低く。その後、選択機構が上位k個のキー値エントリのみを取得します。

重要な洞察は、コンテキストの長さに関係なく、1クエリごとに選ばれるトークンはわずか2,048個ということです。高価な注意計算はこの小さな部分集合で行われ、128Kの全シーケンスではありません。

注意が少なければ、結果は良くなります。DeepSeek V3.2がそれを証明しました。

結果は以下の通りです:

128Kのコンテキストでは、プリフィルコストは100万トークンあたり~$0.65から~$0.35に下がります。復号料金は~$2.4から~$0.8に下がります。

そしてパフォーマンスは?そのままです。一部の長期コンテキストベンチマークでは、V3.2の方が実際により高いスコアを得ています。

注目が少なくなるのは新しいことではありません。品質を落とさずにうまく機能させるのは難しいです。

DeepSeekは2段階のトレーニングプロセスでこれを解き、まずKL発散を使ってインデクサーを整列し、次にモデル全体をスパースパターンに適応させる訓練を行いました。

これがコストを上げずにコンテキストをスケールさせる方法です。

...

トップ

ランキング

お気に入り