Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A DeepSeek quebrou o gargalo de atenção O(L²).

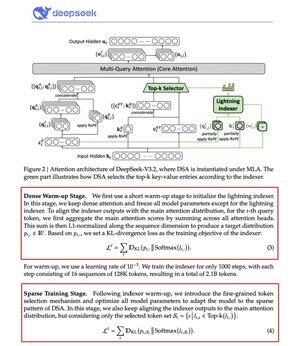

O seu novo modelo V3.2 introduz a Atenção Esparsa DeepSeek (DSA), e essa é a única mudança arquitetônica que fizeram. Isso mostra o quão importante isso é.

O que isso resolve:

A atenção padrão escala quadraticamente. Dobre o comprimento do contexto, quadruplica o cálculo. É por isso que a inferência de longo contexto se torna cara rapidamente.

A DSA reduz a complexidade de O(L²) para O(Lk), onde k é fixo.

Como funciona:

Um Indexador Lightning leve classifica quais tokens realmente importam para cada consulta. Um pequeno número de cabeças, funciona em FP8, computacionalmente barato. Em seguida, um mecanismo de seleção recupera apenas as entradas chave-valor top-k.

A grande sacada: apenas 2.048 tokens são selecionados por consulta, independentemente do comprimento do contexto. O cálculo de atenção caro acontece nesse pequeno subconjunto, não na sequência completa de 128K.

Menos atenção, melhores resultados. A DeepSeek V3.2 acabou de provar isso.

Os resultados:

Com 128K de contexto, os custos de pré-preenchimento caem de ~$0.65 para ~$0.35 por milhão de tokens. A decodificação cai de ~$2.4 para ~$0.8.

E o desempenho? Permanece o mesmo. Em alguns benchmarks de longo contexto, a V3.2 na verdade pontua mais alto.

A atenção esparsa não é nova. Fazer funcionar sem perder qualidade é difícil.

A DeepSeek conseguiu isso com um processo de treinamento em duas etapas, primeiro alinhando o indexador usando divergência KL, depois treinando o modelo completo para se adaptar a padrões esparsos.

É assim que você escala o contexto sem aumentar os custos.

...

Top

Classificação

Favoritos