Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek đã giải quyết được nút thắt O(L²) trong attention.

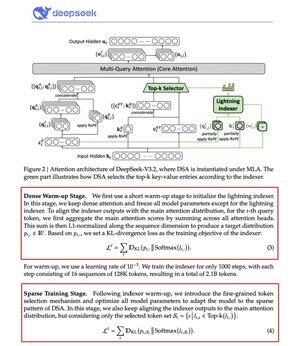

Mô hình V3.2 mới của họ giới thiệu DeepSeek Sparse Attention (DSA), và đó là thay đổi kiến trúc duy nhất mà họ thực hiện. Điều đó cho thấy tầm quan trọng của nó.

Nó giải quyết vấn đề gì:

Attention tiêu chuẩn tăng theo cấp số bậc hai. Gấp đôi độ dài ngữ cảnh, gấp bốn lần tính toán. Đây là lý do tại sao suy diễn với ngữ cảnh dài trở nên tốn kém nhanh chóng.

DSA giảm độ phức tạp từ O(L²) xuống O(Lk), trong đó k là cố định.

Cách nó hoạt động:

Một Lightning Indexer nhẹ nhàng đánh giá các token nào thực sự quan trọng cho mỗi truy vấn. Số lượng đầu nhỏ, chạy ở FP8, chi phí tính toán thấp. Sau đó, một cơ chế lựa chọn chỉ lấy các mục key-value hàng đầu-k.

Điểm mấu chốt: chỉ 2.048 token được chọn cho mỗi truy vấn, bất kể độ dài ngữ cảnh. Tính toán attention tốn kém diễn ra trên tập con nhỏ này, không phải toàn bộ chuỗi 128K.

Ít attention, kết quả tốt hơn. DeepSeek V3.2 vừa chứng minh điều đó.

Kết quả:

Tại ngữ cảnh 128K, chi phí tiền lấp đầy giảm từ ~$0.65 xuống ~$0.35 cho mỗi triệu token. Giải mã giảm từ ~$2.4 xuống ~$0.8.

Và hiệu suất? Vẫn giữ nguyên. Trên một số benchmark ngữ cảnh dài, V3.2 thực sự đạt điểm cao hơn.

Sparse attention không phải là mới. Làm cho nó hoạt động mà không làm mất chất lượng là điều khó khăn.

DeepSeek đã giải quyết điều đó với quy trình đào tạo hai giai đoạn, đầu tiên là căn chỉnh indexer bằng KL-divergence, sau đó đào tạo mô hình đầy đủ để thích ứng với các mẫu thưa.

Đây là cách bạn mở rộng ngữ cảnh mà không làm tăng chi phí.

...

Hàng đầu

Thứ hạng

Yêu thích