Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DeepSeek a rezolvat blocajul atenției O(L²).

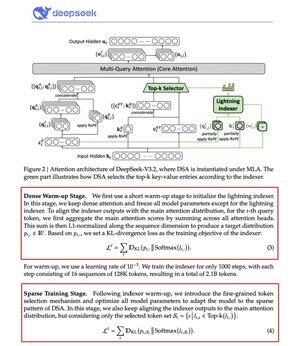

Noul lor model V3.2 introduce DeepSeek Sparse Attention (DSA), iar aceasta este singura modificare arhitecturală făcută. Asta îți spune cât de important este acest lucru.

Ce rezolvă:

Atenția standard se scalează în mod cuadratical. Dublează lungimea contextului, cvadruplează calculul. De aceea inferența pe context lung devine rapid costisitoare.

DSA reduce complexitatea de la O(L²) la O(Lk), unde k este fix.

Cum funcționează:

Un Lightning Indexer ușor evaluează ce tokenuri contează cu adevărat pentru fiecare interogare. Număr mic de capete, rulează în FP8, este ieftin din punct de vedere computațional. Apoi, un mecanism de selecție recuperează doar primele k intrări cheie-valoare.

Ideea cheie: doar 2.048 de tokenuri sunt selectate pe interogare, indiferent de lungimea contextului. Calculul scump al atenției are loc pe acest subset mic, nu pe întreaga secvență de 128K.

Mai puțină atenție, rezultate mai bune. DeepSeek V3.2 tocmai a demonstrat asta.

Rezultatele:

La un context de 128K, costurile de preumplere scad de la ~0,65 la ~0,35 dolari pe milion de tokenuri. Decodarea scade de la ~$2.4 la ~$0.8.

Și performanța? Rămâne la fel. Pe unele benchmark-uri cu context lung, versiunea 3.2 obține de fapt scoruri mai mari.

Atenția slabă nu este ceva nou. Să faci să funcționeze fără să pierzi calitatea este greu.

DeepSeek a reușit să o rezolve printr-un proces de antrenament în două etape, aliniind mai întâi indexatorul folosind divergența KL, apoi antrenând modelul complet să se adapteze la modele rare.

Așa scalezi contextul fără a scala costurile.

...

Limită superioară

Clasament

Favorite