Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

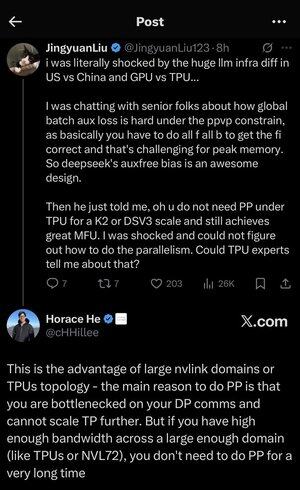

Je me suis un peu perdu dans tous les acronymes et le jargon ici, alors j'ai demandé à Claude de l'expliquer sans utiliser d'acronymes et maintenant tout a parfaitement du sens (tldr; bande passante ⟹ simplicité) :

C'est une discussion technique fascinante sur l'entraînement de grands modèles de langage à grande échelle.

La Conversation Principale

Jingyuan Liu exprime sa surprise de découvrir qu'il n'est pas nécessaire d'utiliser certaines techniques d'optimisation complexes lors de l'utilisation de TPUs (Tensor Processing Units - les puces AI spécialisées de Google) par rapport aux GPUs (Graphics Processing Units - généralement les puces de NVIDIA).

Concepts Techniques Clés Expliqués :

Types de Matériel :

•GPU (Graphics Processing Unit) : À l'origine conçu pour les graphiques, maintenant largement utilisé pour l'IA. NVIDIA domine ce marché.

•TPU (Tensor Processing Unit) : Puces conçues sur mesure par Google spécifiquement pour l'apprentissage automatique.

Stratégies de Parallélisme :

Lors de l'entraînement de modèles d'IA massifs, vous devez répartir le travail sur de nombreuses puces. Il existe plusieurs façons de le faire :

1) Parallélisme de Données (DP) : Chaque puce traite différents lots de données avec la même copie du modèle.

2) Parallélisme de Tenseur (TP) : Les opérations mathématiques du modèle sont réparties sur les puces.

3) Parallélisme de Pipeline (PP) : Différentes couches du modèle sont placées sur différentes puces, créant un pipeline.

Le Défi Technique Discuté :

Le problème de la perte auxiliaire : Lors de l'entraînement de modèles très grands, vous ajoutez souvent des "pertes auxiliaires" (objectifs d'entraînement supplémentaires) à des couches intermédiaires pour aider les gradients à mieux circuler dans le réseau. Sous les contraintes de PPVP (Parallélisme de Pipeline avec Partitionnement Variable), cela devient complexe car :

...

Meilleurs

Classement

Favoris