Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

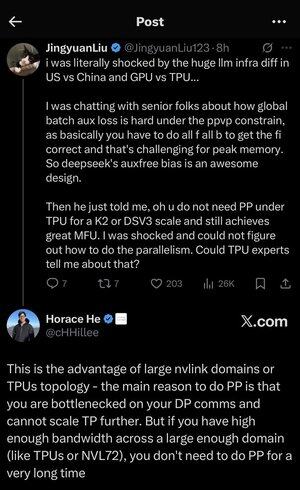

Mi sono un po' perso in tutti gli acronimi e il gergo qui, quindi ho fatto spiegare a Claude senza usare acronimi e ora ha tutto perfettamente senso (tldr; larghezza di banda ⟹ semplicità):

Questa è una discussione tecnica affascinante sulla formazione di modelli di linguaggio di grandi dimensioni su larga scala.

La Conversazione Principale

Jingyuan Liu esprime sorpresa nel scoprire che non hai bisogno di certe tecniche di ottimizzazione complesse quando usi TPU (Tensor Processing Units - i chip AI specializzati di Google) rispetto a GPU (Graphics Processing Units - tipicamente i chip NVIDIA).

Concetti Tecnici Chiave Spiegati:

Tipi di Hardware:

•GPU (Graphics Processing Unit): Originariamente progettata per la grafica, ora ampiamente utilizzata per l'AI. NVIDIA domina questo mercato.

•TPU (Tensor Processing Unit): Chip progettati su misura da Google specificamente per l'apprendimento automatico.

Strategie di Parallelismo:

Quando si addestrano modelli AI massicci, è necessario suddividere il lavoro tra molti chip. Ci sono diversi modi per farlo:

1) Parallelismo Dati (DP): Ogni chip elabora diversi lotti di dati con la stessa copia del modello

2) Parallelismo Tensoriale (TP): Le operazioni matematiche del modello sono suddivise tra i chip

3) Parallelismo a Pipeline (PP): Diversi strati del modello sono posizionati su chip diversi, creando una pipeline

La Sfida Tecnica In Discussione:

Il problema della perdita ausiliaria: Quando si addestrano modelli molto grandi, spesso si aggiungono "perdite ausiliarie" (obiettivi di addestramento aggiuntivi) a strati intermedi per aiutare i gradienti a fluire meglio attraverso la rete. Sotto i vincoli di PPVP (Pipeline Parallelism with Variable Partitioning), questo diventa complesso perché:

...

Principali

Ranking

Preferiti