Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

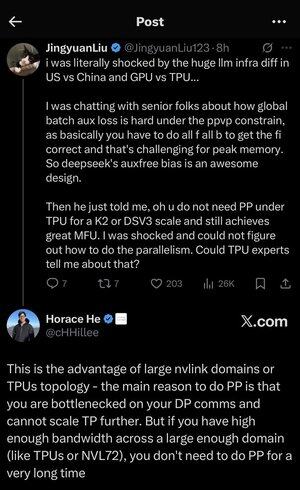

Ich habe mich ein wenig in all den Abkürzungen und dem Fachjargon hier verloren, also ließ ich Claude es mir ohne Abkürzungen erklären und jetzt macht alles perfekten Sinn (kurz gesagt; Bandbreite ⟹ Einfachheit):

Dies ist eine faszinierende technische Diskussion über das Training großer Sprachmodelle im großen Maßstab.

Das Kern-Gespräch

Jingyuan Liu äußert Überraschung darüber, dass man bestimmte komplexe Optimierungstechniken nicht benötigt, wenn man TPUs (Tensor Processing Units - Googles spezialisierte KI-Chips) im Vergleich zu GPUs (Graphics Processing Units - typischerweise NVIDIA-Chips) verwendet.

Wichtige technische Konzepte erklärt:

Hardwaretypen:

•GPU (Graphics Processing Unit): Ursprünglich für Grafiken entwickelt, jetzt stark für KI genutzt. NVIDIA dominiert diesen Markt.

•TPU (Tensor Processing Unit): Googles maßgeschneiderte Chips speziell für maschinelles Lernen.

Parallelitätsstrategien:

Beim Training massiver KI-Modelle muss man die Arbeit auf viele Chips aufteilen. Es gibt mehrere Möglichkeiten, dies zu tun:

1) Datenparallelismus (DP): Jeder Chip verarbeitet unterschiedliche Datenbatches mit derselben Modellkopie.

2) Tensorparallelismus (TP): Die mathematischen Operationen des Modells werden auf Chips aufgeteilt.

3) Pipeline-Parallelismus (PP): Verschiedene Schichten des Modells werden auf verschiedenen Chips platziert, wodurch eine Pipeline entsteht.

Die technische Herausforderung, die diskutiert wird:

Das Problem des Hilfsverlusts: Beim Training sehr großer Modelle fügt man oft "Hilfsverluste" (zusätzliche Trainingsziele) in Zwischenebenen hinzu, um den Fluss der Gradienten durch das Netzwerk zu verbessern. Unter den PPVP (Pipeline-Parallelismus mit variabler Partitionierung) Einschränkungen wird dies komplex, weil:

...

Top

Ranking

Favoriten