المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

لقد ضاعت قليلا في جميع الاختصارات والمصطلحات هنا ، لذلك طلبت من كلود شرحها دون استخدام أي اختصارات والآن كل شيء منطقي تماما (tldr ؛ النطاق الترددي ⟹ البساطة):

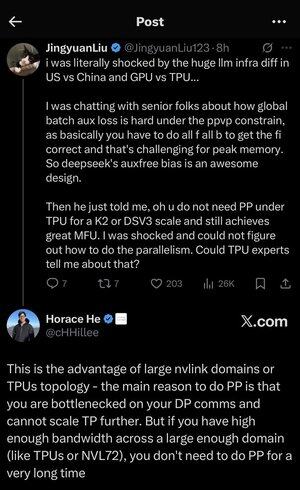

هذه مناقشة فنية رائعة حول تدريب نماذج لغوية كبيرة على نطاق واسع.

المحادثة الأساسية

يعرب Jingyuan Liu عن دهشته من اكتشاف أنك لست بحاجة إلى تقنيات تحسين معقدة معينة عند استخدام TPUs (وحدات معالجة Tensor - رقائق الذكاء الاصطناعي المتخصصة من Google) مقابل وحدات معالجة الرسومات (وحدات معالجة الرسومات - عادة رقائق NVIDIA).

شرح المفاهيم الفنية الرئيسية:

أنواع الأجهزة:

•وحدة معالجة الرسومات: مصممة في الأصل للرسومات، وتستخدم الآن بكثافة في الذكاء الاصطناعي. تهيمن NVIDIA على هذا السوق.

•TPU (وحدة معالجة الموتر): رقائق Google المصممة خصيصا للتعلم الآلي.

استراتيجيات التوازي:

عند تدريب نماذج الذكاء الاصطناعي الضخمة ، تحتاج إلى تقسيم العمل عبر العديد من الرقائق. هناك عدة طرق للقيام بذلك:

1) توازي البيانات (DP): تعالج كل شريحة دفعات مختلفة من البيانات بنفس نسخة النموذج

2) توازي الموتر (TP): يتم تقسيم العمليات الرياضية للنموذج عبر الرقائق

3) توازي خطوط الأنابيب (PP): يتم وضع طبقات مختلفة من النموذج على رقائق مختلفة ، مما يؤدي إلى إنشاء خط أنابيب

التحدي الفني الذي تتم مناقشته:

مشكلة الخسارة المساعدة: عند تدريب النماذج الكبيرة جدا ، غالبا ما تضيف "خسائر مساعدة" (أهداف تدريب إضافية) في الطبقات الوسيطة لمساعدة التدرجات على التدفق بشكل أفضل عبر الشبكة. في ظل قيود PPVP (التوازي بين خط الأنابيب والتقسيم المتغير) ، يصبح هذا معقدا للأسباب التالية:

...

الأفضل

المُتصدِّرة

التطبيقات المفضلة