Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeg gikk meg litt vill i alle akronymene og sjargongen her, så jeg fikk Claude til å forklare det uten å bruke noen akronymer, og nå gir det hele perfekt mening (tldr; båndbredde ⟹ enkelhet):

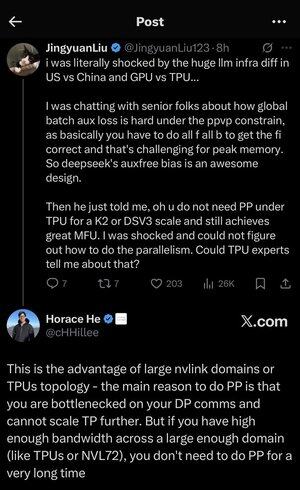

Dette er en fascinerende teknisk diskusjon om trening av store språkmodeller i stor skala.

Kjernesamtalen

Jingyuan Liu uttrykker overraskelse over å oppdage at du ikke trenger visse komplekse optimaliseringsteknikker når du bruker TPU-er (Tensor Processing Units - Googles spesialiserte AI-brikker) kontra GPUer (Graphics Processing Units - vanligvis NVIDIAs brikker).

Viktige tekniske konsepter forklart:

Maskinvare typer:

•GPU (Graphics Processing Unit): Opprinnelig designet for grafikk, nå mye brukt for AI. NVIDIA dominerer dette markedet.

•TPU (Tensor Processing Unit): Googles spesialdesignede brikker spesielt for maskinlæring.

Parallellisme strategier:

Når du trener massive AI-modeller, må du dele arbeidet på tvers av mange brikker. Det er flere måter å gjøre dette på:

1) Dataparallellitet (DP): Hver brikke behandler forskjellige datapartier med samme modellkopi

2) Tensorparallellitet (TP): Modellens matematiske operasjoner er delt på brikker

3) Pipeline Parallelism (PP): Ulike lag av modellen er plassert på forskjellige brikker, og skaper en rørledning

Den tekniske utfordringen som diskuteres:

Hjelpetapsproblemet: Når du trener veldig store modeller, legger du ofte til "hjelpetap" (ekstra treningsmål) på mellomlag for å hjelpe gradienter til å flyte bedre gjennom nettverket. Under PPVP-begrensninger (Pipeline Parallelism with Variable Partitioning) blir dette komplisert fordi:

...

Topp

Rangering

Favoritter