Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Я трохи загубився у всіх абревіатурах і жаргоні тут, тому я попросив Клода пояснити це без використання будь-яких абревіатур, і тепер все це має сенс (tldr; пропускна здатність ⟹ простота):

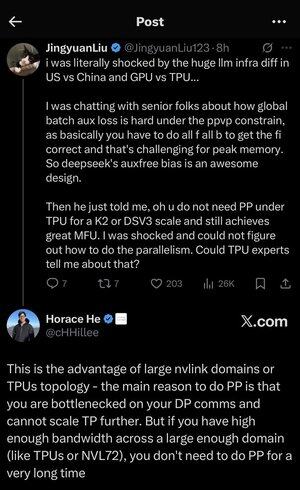

Це захоплююча технічна дискусія про навчання великих мовних моделей у масштабі.

Суть розмови

Цзін'юань Лю висловлює здивування, виявивши, що вам не потрібні певні складні методи оптимізації при використанні TPU (тензорні процесори - спеціалізовані чіпи штучного інтелекту Google) у порівнянні з графічними процесорами (графічними процесорами - зазвичай чіпами NVIDIA).

Пояснення ключових технічних понять:

Типи фурнітури:

•Графічний процесор (графічний процесор): спочатку розроблений для графіки, а зараз активно використовується для штучного інтелекту. NVIDIA домінує на цьому ринку.

•TPU (тензорний процесор): спеціально розроблені чіпи Google спеціально для машинного навчання.

Стратегії паралелізму:

Під час навчання масивних моделей штучного інтелекту вам потрібно розділити роботу на багато чіпів. Для цього є кілька способів:

1) Паралелізм даних (DP): кожен чіп обробляє різні пакети даних з однією і тією ж копією моделі

2) Тензорний паралелізм (ТП): математичні операції моделі розподілені між мікросхемами

3) Паралельність трубопроводу (PP): різні шари моделі розміщуються на різних чіпах, створюючи конвеєр

Технічна задача, що обговорюється:

Проблема допоміжних втрат: при навчанні дуже великих моделей ви часто додаєте «допоміжні втрати» (додаткові тренувальні цілі) на проміжних рівнях, щоб допомогти градієнтам краще протікати через мережу. За обмежень PPVP (Pipeline Parallelism with Variable Partitioning) це стає складним, оскільки:

...

Найкращі

Рейтинг

Вибране