Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

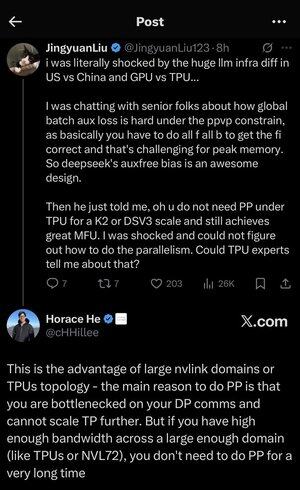

Me perdí un poco en todos los acrónimos y la jerga aquí, así que le pedí a Claude que lo explicara sin usar ningún acrónimo y ahora todo tiene mucho sentido (tldr; ancho de banda ⟹ simplicidad):

Esta es una discusión técnica fascinante sobre el entrenamiento de grandes modelos de lenguaje a escala.

La conversación central

Jingyuan Liu está expresando su sorpresa al descubrir que no necesita ciertas técnicas de optimización complejas cuando se usan TPU (Unidades de procesamiento tensorial, los chips de IA especializados de Google) frente a GPU (Unidades de procesamiento de gráficos, generalmente los chips de NVIDIA).

Explicación de conceptos técnicos clave:

Tipos de hardware:

•GPU (Unidad de procesamiento de gráficos): Originalmente diseñada para gráficos, ahora muy utilizada para IA. NVIDIA domina este mercado.

• TPU (Tensor Processing Unit): los chips diseñados a medida de Google específicamente para el aprendizaje automático.

Estrategias de paralelismo:

Al entrenar modelos masivos de IA, debe dividir el trabajo en muchos chips. Hay varias formas de hacer esto:

1) Paralelismo de datos (DP): cada chip procesa diferentes lotes de datos con la misma copia del modelo

2) Paralelismo tensorial (TP): Las operaciones matemáticas del modelo se dividen en chips

3) Paralelismo de tubería (PP): Diferentes capas del modelo se colocan en diferentes chips, creando una tubería

El desafío técnico que se está discutiendo:

El problema de la pérdida auxiliar: al entrenar modelos muy grandes, a menudo se agregan "pérdidas auxiliares" (objetivos de entrenamiento adicionales) en las capas intermedias para ayudar a que los gradientes fluyan mejor a través de la red. Bajo las restricciones PPVP (Paralelismo de canalización con partición de variables), esto se vuelve complejo porque:

...

Populares

Ranking

Favoritas