Trend Olan Konular

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

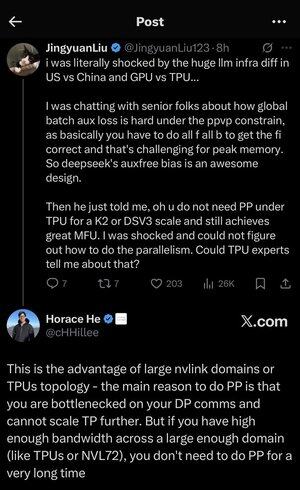

Buradaki tüm kısaltmalar ve jargon arasında biraz kayboldum, bu yüzden Claude'a herhangi bir kısaltma kullanmadan açıklamasını sağladım ve şimdi her şey mükemmel bir anlam ifade ediyor (tldr; bant genişliği ⟹ basitlik):

Bu, büyük dil modellerinin geniş ölçekte eğitimi hakkında büyüleyici bir teknik tartışmadır.

Temel Konuşma

Jingyuan Liu, TPU'ları (Tensör İşleme Birimleri - Google'ın özel AI çipleri) GPU'lara (Grafik İşleme Birimleri - tipik olarak NVIDIA'nın çipleri) karşı kullanırken belirli karmaşık optimizasyon tekniklerine ihtiyacınız olmadığını keşfetmekten duyduğu şaşkınlığı ifade ediyor.

Açıklanan Temel Teknik Kavramlar:

Donanım Türleri:

•GPU (Grafik İşlem Birimi): Başlangıçta grafikler için tasarlandı, şimdi AI için yoğun olarak kullanılıyor. NVIDIA bu pazara hakimdir.

•TPU (Tensör İşleme Birimi): Google'ın makine öğrenimi için özel olarak tasarladığı çipler.

Paralellik Stratejileri:

Büyük yapay zeka modellerini eğitirken, işi birçok çipe bölmeniz gerekir. Bunu yapmanın birkaç yolu vardır:

1) Veri Paralelliği (DP): Her çip, aynı model kopyasıyla farklı veri gruplarını işler

2) Tensör Paralelliği (TP): Modelin matematiksel işlemleri çipler arasında bölünmüştür

3) Boru Hattı Paralelliği (PP): Modelin farklı katmanları farklı yongalar üzerine yerleştirilerek bir boru hattı oluşturulur

Tartışılan teknik zorluk:

Yardımcı kayıp sorunu: Çok büyük modelleri eğitirken, gradyanların ağ üzerinden daha iyi akmasına yardımcı olmak için genellikle ara katmanlara "yardımcı kayıplar" (ek eğitim hedefleri) eklersiniz. PPVP (Değişken Bölümlemeli Boru Hattı Paralelliği) kısıtlamaları altında bu karmaşık hale gelir çünkü:

...

En İyiler

Sıralama

Takip Listesi