Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zgubiłem się trochę w tych wszystkich akronimach i żargonie, więc poprosiłem Claude'a, aby wyjaśnił to bez używania jakichkolwiek akronimów i teraz wszystko ma sens (tldr; przepustowość ⟹ prostota):

To fascynująca dyskusja techniczna na temat trenowania dużych modeli językowych na dużą skalę.

Główna rozmowa

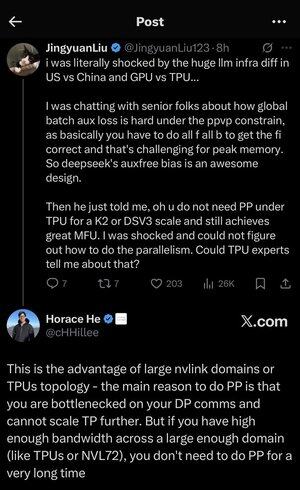

Jingyuan Liu wyraża zdziwienie odkryciem, że nie potrzebujesz pewnych skomplikowanych technik optymalizacji przy użyciu TPU (Tensor Processing Units - specjalizowane chipy AI Google'a) w porównaniu do GPU (Graphics Processing Units - typowo chipy NVIDIA).

Kluczowe pojęcia techniczne wyjaśnione:

Rodzaje sprzętu:

•GPU (Graphics Processing Unit): Początkowo zaprojektowane do grafiki, teraz intensywnie wykorzystywane w AI. NVIDIA dominuje na tym rynku.

•TPU (Tensor Processing Unit): Niestandardowe chipy zaprojektowane przez Google specjalnie do uczenia maszynowego.

Strategie równoległości:

Podczas trenowania ogromnych modeli AI, musisz podzielić pracę na wiele chipów. Istnieje kilka sposobów, aby to zrobić:

1) Równoległość danych (DP): Każdy chip przetwarza różne partie danych z tą samą kopią modelu.

2) Równoległość tensorowa (TP): Operacje matematyczne modelu są dzielone między chipy.

3) Równoległość potokowa (PP): Różne warstwy modelu są umieszczane na różnych chipach, tworząc potok.

Techniczne wyzwanie, które jest omawiane:

Problem strat pomocniczych: Podczas trenowania bardzo dużych modeli często dodajesz "straty pomocnicze" (dodatkowe cele treningowe) na warstwach pośrednich, aby pomóc gradientom lepiej przepływać przez sieć. W ramach ograniczeń PPVP (Pipeline Parallelism with Variable Partitioning) staje się to skomplikowane, ponieważ:

...

Najlepsze

Ranking

Ulubione