Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

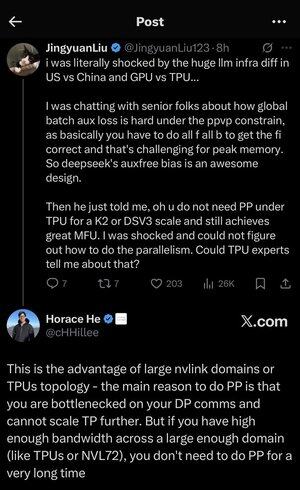

Trochu jsem se ztratil ve všech těch zkratkách a žargonu, takže jsem si nechal od Clauda vysvětlit bez použití zkratek a teď to všechno dává dokonalý smysl (tldr; šířka pásma ⟹ jednoduchost):

Toto je fascinující technická diskuse o trénování velkých jazykových modelů ve velkém měřítku.

Základní konverzace

Jingyuan Liu vyjadřuje překvapení nad zjištěním, že při používání TPU (Tensor Processing Units - specializované AI čipy Google) oproti GPU (Graphics Processing Units - typicky čipy NVIDIA) nepotřebujete určité složité optimalizační techniky.

Vysvětlení klíčových technických pojmů:

Typy hardwaru:

•GPU (Graphics Processing Unit): Původně navržený pro grafiku, nyní se hojně používá pro umělou inteligenci. NVIDIA tomuto trhu dominuje.

•TPU (Tensor Processing Unit): Čipy navržené na míru společnosti Google speciálně pro strojové učení.

Strategie paralelismu:

Při trénování masivních modelů umělé inteligence je potřeba rozdělit práci na mnoho čipů. To lze provést několika způsoby:

1) Datový paralelismus (DP): Každý čip zpracovává různé dávky dat se stejnou kopií modelu

2) Tenzorový paralelismus (TP): Matematické operace modelu jsou rozděleny mezi čipy

3) Paralelismus potrubí (PP): Různé vrstvy modelu jsou umístěny na různých čipech, čímž se vytvoří potrubí

Diskutovaná technická výzva:

Problém pomocných ztrát: Při trénování velmi velkých modelů často přidáváte "pomocné ztráty" (dodatečné cíle trénování) do mezilehlých vrstev, aby gradienty lépe proudily sítí. Při omezeních PPVP (Pipeline Parallelism with Variable Partitioning) se to stává složitým, protože:

...

Top

Hodnocení

Oblíbené