Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Saya sedikit tersesat dalam semua akronim dan jargon di sini, jadi saya meminta Claude menjelaskannya tanpa menggunakan akronim apa pun dan sekarang semuanya sangat masuk akal (tldr; bandwidth ⟹ kesederhanaan):

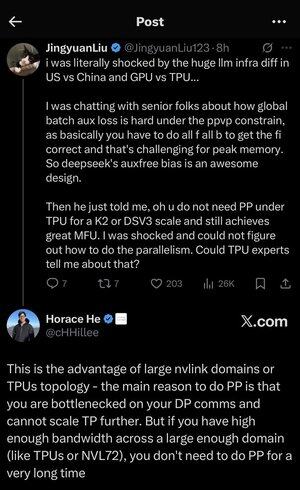

Ini adalah diskusi teknis yang menarik tentang pelatihan model bahasa besar dalam skala besar.

Percakapan Inti

Jingyuan Liu mengungkapkan keterkejutannya karena menemukan bahwa Anda tidak memerlukan teknik pengoptimalan kompleks tertentu saat menggunakan TPU (Tensor Processing Units - chip AI khusus Google) versus GPU (Graphics Processing Units - biasanya chip NVIDIA).

Konsep Teknis Utama Dijelaskan:

Jenis Perangkat Keras:

•GPU (Graphics Processing Unit): Awalnya dirancang untuk grafik, sekarang banyak digunakan untuk AI. NVIDIA mendominasi pasar ini.

• TPU (Tensor Processing Unit): Chip Google yang dirancang khusus khusus untuk pembelajaran mesin.

Strategi Paralelisme:

Saat melatih model AI besar-besaran, Anda perlu membagi pekerjaan ke banyak chip. Ada beberapa cara untuk melakukan ini:

1) Paralelisme Data (DP): Setiap chip memproses batch data yang berbeda dengan salinan model yang sama

2) Tensor Parallelism (TP): Operasi matematika model dibagi di seluruh chip

3) Paralelisme Pipa (PP): Lapisan model yang berbeda ditempatkan pada chip yang berbeda, menciptakan pipa

Tantangan teknis yang sedang dibahas:

Masalah kehilangan tambahan: Saat melatih model yang sangat besar, Anda sering menambahkan "kerugian tambahan" (tujuan pelatihan tambahan) pada lapisan perantara untuk membantu gradien mengalir lebih baik melalui jaringan. Di bawah batasan PPVP (Pipeline Parallelism with Variable Partitioning), ini menjadi kompleks karena:

...

Teratas

Peringkat

Favorit