トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

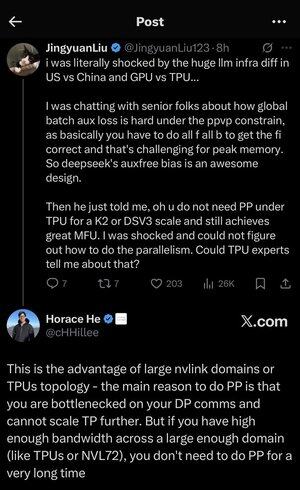

私はここでのすべての頭字語と専門用語に少し迷ったので、頭字語を使わずにClaudeに説明してもらいましたが、今ですべてが完全に理にかなっています(tldr; 帯域幅⟹ シンプルさ):

これは、大規模な言語モデルの大規模なトレーニングに関する興味深い技術的議論です。

核となる会話

Jingyuan Liu 氏は、TPU (Tensor Processing Units - Google の特殊な AI チップ) と GPU (グラフィックス プロセッシング ユニット - 通常は NVIDIA のチップ) を使用する場合に、特定の複雑な最適化技術が必要ないことを発見して驚きを表明しています。

主要な技術概念の説明:

ハードウェアの種類:

•GPU(グラフィックスプロセッシングユニット):元々はグラフィックス用に設計されましたが、現在はAIに多用されています。NVIDIA はこの市場を支配しています。

•TPU(Tensor Processing Unit):機械学習専用のGoogleのカスタム設計チップ。

並列処理戦略:

大規模な AI モデルをトレーニングする場合、作業を多くのチップに分割する必要があります。これを行うには、いくつかの方法があります。

1) データ並列処理 (DP): 各チップは、同じモデル コピーで異なるバッチのデータを処理します

2) テンソル並列処理 (TP): モデルの数学演算はチップ間で分割されます

3) パイプライン並列処理 (PP): モデルのさまざまなレイヤーがさまざまなチップに配置され、パイプラインが作成されます

議論されている技術的課題:

補助損失の問題: 非常に大規模なモデルをトレーニングする場合、勾配がネットワーク内をより適切に流れるように、中間層に「補助損失」(追加のトレーニング目標)を追加することがよくあります。PPVP (Pipeline Parallelism with Variable Partitioning) 制約では、次の理由でこれが複雑になります。

...

トップ

ランキング

お気に入り