Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Meta

Gamefi-Veteran

Investitionen und Investitionen in Primär- und Sekundärprojekte

🏅Mitbegründer @Opensky_888

🏅 Kernmitglieder @InFuture_Web3

Seit @0G_labs und Web3Labs den 0G Global Accelerator ins Leben gerufen haben, haben viele Start-up-Teams weltweit ihre Projekte eingereicht. Obwohl die ausgewählten Projekte bisher noch nicht bekannt gegeben wurden, freuen sich alle auf den Demo Day, der am 29. August in Hongkong stattfinden wird. Gemeinsam ist diesen Bewerbungsprojekten, dass sie sich intensiv mit dem Technologie-Stack von 0G auseinandersetzen.

Einige Schlüsselbereiche, die im Fokus von 0G stehen 🎯

1️⃣ KI-gesteuerte Prognosemärkte

Traditionelle Prognosemärkte wie Polymarket verlassen sich weiterhin auf manuell erstellte und umstrittene Lösungsmechanismen, während diese neuen Projekte selbstverbessernde Orakel-Netzwerke und multimodale Lösungsmechanismen erkunden. Ein Projekt entwickelt sogar ein neues Modell, das Glauben mit Preisen verknüpft, unterstützt durch KI-gesteuerte Markterschaffung und Ergebnisvalidierung.

2️⃣ Native KI-Handelsplattformen

Es geht nicht darum, KI-Funktionen auf bestehenden DeFi-Plattformen hinzuzufügen, sondern darum, eine native Ausführungsumgebung für KI-Agenten von Grund auf neu zu schaffen. Einige Projekte integrieren dynamisch Datenströme über Märkte hinweg mit MCP, sodass das System sich kontinuierlich an die sich ändernden Marktbedingungen anpassen kann.

3️⃣ Tokenisierte KI-Agenten/Smart NFTs

Der ERC-7857 iNFT-Standard von 0G ermöglicht die Erstellung, den Besitz, das Training und die Monetarisierung von On-Chain-KI-Agenten. Derzeit erkunden mehrere Projekte den Übergang vom Verbrauchermarkt für Agenten zu vollständig handelbaren iNFT-gesteuerten Dienstleistungen.

4️⃣ Dezentralisierte Wissenschaft

DeSci-Projekte konzentrieren sich hauptsächlich auf die Kombination von KI mit Datenbesitz und -speicherung, was perfekt zu 0Gs Speicheranwendungsmodulen und der Wertvorstellung von KI als öffentlichem Gut passt.

@0G_labs ist das erste KI-native L1 und bietet durch modulare Architektur, verifizierbare Schlussfolgerungen und eine speziell für KI entwickelte Ausführungsebene die fehlende Infrastruktur, um KI vollständig on-chain zu bringen.

Diese Signale zeigen, dass die Entwickler nach einer technischen Grundlage suchen, die es Agenten, Modellen und Daten ermöglicht, vertrauenslos zu operieren, wobei Kombinierbarkeit eine Standardfunktion ist. Dies steht im Einklang mit der Designphilosophie von 0G.

15,91K

Immer mehr Menschen beginnen zu erkennen, dass AI einen "Hard Fork" durchläuft. Von den früheren "großen Modellen", die alles machen wollten, bewegt man sich langsam hin zu fokussierteren "spezialisierten Modellen". Die fünf Gründe, die in einem Tweet von @OpenledgerHQ erwähnt werden, spiegeln die Entscheidungen wider, die die gesamte Branche trifft.

Aus der Perspektive der praktischen Anwendung ist allgemeine AI wie ein Alleskönner, der alles tun kann, aber nichts wirklich gut macht. Spezialisierte AI hingegen ist eine maßgeschneiderte Lösung für spezifische Szenarien.

🎯 Zielgerichtete Problemlösung

Spezialisierte AI-Modelle sind tiefgehend für bestimmte Bereiche optimiert. AI muss keine irrelevanten Daten und Szenarien verarbeiten; alle Rechenleistung und Parameter konzentrieren sich darauf, ein Problem in einem vertikalen Bereich zu lösen. Diese Fokussierung führt zu exponentiellen Verbesserungen.

🔍 Erklärbarkeit wird zur Notwendigkeit

In hochriskanten Szenarien wie dem Finanzwesen kann man sich nicht nur auf Black-Box-Antworten verlassen. Regulierungsanforderungen, Compliance-Bedürfnisse und Verantwortungszuweisungen erfordern, dass jeder Schritt des AI-Argumentationsprozesses nachvollziehbar und überprüfbar ist. Spezialisierte Modelle können Entscheidungswege für spezifische Szenarien entwerfen.

⛓️ On-Chain-Verifizierung und Vertrauensmechanismen

Blockchain-Technologie ermöglicht es, den Argumentationsprozess der AI dauerhaft aufzuzeichnen und zu verifizieren. Spezialisierte AI in Kombination mit On-Chain-Nachweisen kann eine vollständige Vertrauenskette aufbauen. Jeder Argumentationsschritt und jeder Entscheidungsprozess ist nachvollziehbar, was für Unternehmen, die Audits und Compliance benötigen, unerlässlich ist.

📊 Lösung des Halluzinationsproblems

Die Halluzinationen der allgemeinen AI resultieren größtenteils aus der Komplexität und Vielfalt der Trainingsdaten. Spezialisierte AI kann die Halluzinationsrate erheblich senken, indem sie den Umfang und die Qualität der Trainingsdaten einschränkt. In vertikalen Bereichen sind die Datenqualitäten kontrollierbar, die Wissensgrenzen klar, und das Modell kann genauere und zuverlässigere Antworten geben.

💰 Neuberechnung der Kosten-Nutzen-Relation

Obwohl es so aussieht, als könnte ein allgemeines AI-Modell alle Probleme lösen, sind die tatsächlichen Implementierungskosten extrem hoch. Spezialisierte AI kann mit einem kleineren Modell bessere Ergebnisse erzielen, die Kosten für die Argumentation sind niedriger und die Implementierung flexibler.

Die fünf Punkte, die @OpenledgerHQ anführt, sind tatsächlich eine Antwort auf die realen Bedürfnisse der Branche. Es geht nicht nur um einen Wettstreit der Ansätze, sondern um die Wahl zwischen Effizienz und Umsetzbarkeit. Große Modelle stehen für Erkundung, spezialisierte Modelle für Industrialisierung.

Teams wie Openledger, die in der On-Chain-Infrastruktur tätig sind, könnten die Infrastruktur-Anbieter dieser Welle der Veränderung sein.

35,68K

Gestern habe ich das AMA von @anoma gehört und das Gefühl, dass anoma wirklich schnell vorankommt.

Von den Anfängen des Aufbaus von anoma bis hin zu den täglichen Tests im Testnetz fühlt sich die Zeit wirklich schnell an. Von der anfänglichen Aufregung über das bevorstehende TGE bis hin zur jetzigen Gelassenheit. Ich bin sogar ein bisschen wehmütig über das bald endende Testnetz.

Letzte Nacht wurde auch das neue Spiel "Slot Machine" eingeführt. Ich dachte, es würde wie die vorherigen Spiele Fitcoin als Spielwährung verwenden. Überraschenderweise wurde schließlich Points gewählt.

Wie allgemein bekannt ist, bestimmt die Gesamtmenge an Points das Ranking, und unter dem Anreiz der Belohnungen im Testnetz ist die Bedeutung des Rankings unbestreitbar. Ich bin eigentlich der Typ, der oft Pech hat. Gestern habe ich gerade erst angefangen zu zocken und direkt 100.000 Points verloren, was natürlich nicht zurückgeholt werden konnte. Es wird gesagt, dass man den Hauptpreis von 1 Million Points gewinnen kann.

Nach meinem erfolgreichen Zocken heute beträgt mein Gesamtscore 5,56 Millionen, und ich bin ungefähr auf Platz 500. Ich plane, 100 kleine Bälle zu setzen, um zu sehen, was passiert!

Nach dem Zocken beträgt die Gesamtzahl der Points 5,79 Millionen, und ich bin auf Platz 427. Im Vergleich zu den 100 kleinen Bällen, die ich gesetzt habe, habe ich insgesamt 230.000 Points gewonnen. Im Durchschnitt habe ich 2.300 Points pro kleinem Ball gewonnen.

Derzeit wurden im Testnetz insgesamt etwa 25.000 Codes ausgegeben, und die offizielle Schätzung liegt bei 30.000. Es gibt noch 5.000, die nicht gesendet wurden. In die Top 500 zu kommen, entspricht etwa 2 % des Testnetzes. Aber ehrlich gesagt, als ich 100 kleine Bälle gesetzt habe, wollte ich wirklich "absichtlich steuern". Ich wollte ihm sagen, dass ich 100 kleine Bälle setzen möchte, und es hat mir die Kopfhaut gekribbelt🤣

Neben der Interaktion im Testnetz von @anoma, denkt daran, jeden Tag nachzusehen, und wenn ihr einen Beitrag habt, könnt ihr jeden Mittwoch im DC einen Nachweis über den Beitrag einreichen. Die DC-Rolle wird später wahrscheinlich auch im Snapshot sein, also denkt daran, sie zu holen, wenn ihr die Gelegenheit habt. Ein weiterer Punkt, den man beachten sollte, ist NFT; versucht unbedingt, einen zu bekommen. Ich hoffe, dass am Ende alle große Ergebnisse erzielen können!

39,91K

Viele Menschen denken an AI, wenn sie an große LLM-Modelle, intelligente Fragen und Antworten oder AGI-Roadmaps denken, aber nur wenige erkennen wirklich eine Sache: Der zentrale Wertkampf der AI in der Zukunft wird wahrscheinlich nicht im Modell selbst liegen, sondern in den Inhalten, die sie konsumiert, also in IP.

Derzeit wird die globale IP-Wirtschaft auf 61,9 Billionen US-Dollar geschätzt. Das Problem ist, dass diese riesigen Inhaltsressourcen größtenteils in einer Vielzahl von Verträgen, zentralisierten Plattformen, rechtlichen Rahmenbedingungen und geschlossenen Systemen eingeschlossen sind. AI muss viele Hürden überwinden, und es könnte auch zu Problemen kommen.

Deshalb können die meisten aktuellen AI-Modelle nur heimlich Daten sammeln. Artikel, Bilder, Töne und Videos im Internet werden stillschweigend verwendet, um die Modelle zu trainieren. Aber diese Methode kann nicht weiterverfolgt werden, da die Probleme mit dem Urheberrecht, Plattformblockaden und rechtlichen Klagen zunehmen.

Die Idee von @campnetworkxyz ist klar: Nicht blockieren, nicht stehlen, sondern die IP selbst auf die Blockchain bringen, sodass sie zu programmierbaren Vermögenswerten werden, die legal kombiniert und transparent lizenziert werden können.

Das ist auch der solideste Aspekt von Camp. Es geht nicht darum, eine bestimmte AI-Inhaltsplattform zu schaffen, sondern ein grundlegendes Protokoll und eine Infrastruktur zu entwickeln, die es allen Kreativen und IP-Inhabern ermöglicht, ihre Inhalte auf der Blockchain zu registrieren, die Lizenzbedingungen klar zu definieren und die Gewinnverteilung festzulegen. Wenn AI-Modelle verwendet werden sollen, wird einfach nach den Bedingungen bezahlt.

Das Wichtigste ist, dass dieser gesamte Prozess kombinierbar ist. Zukünftige AI-Modelle werden nicht in einer riesigen Blackbox Daten sammeln, sondern wie beim Bau mit Legosteinen, je nach Inhalt, Verwendung und Stil, frei kombinierbare, lizenzierbare Inhaltsmodule anpassen. Der Ausgangspunkt dafür ist, dass jede IP auf die Blockchain gebracht wird und Lizenzbedingungen + Gewinnlogik festgelegt werden.

Die Bedeutung dieser Sache ist enorm, denn sie verwandelt die Beziehung zwischen AI und IP von passivem Extrahieren und Ausbeuten in eine gleichwertige Zusammenarbeit. Kreative sind nicht länger die Opfer von Plagiaten, sondern werden zu Anbietern für das Training von AI und Teilnehmern an kommerziellen Gewinnen.

Ich persönlich stimme der Aussage von @campnetworkxyz zu: "Der größte Markt, den AI berühren wird, ist IP." Egal wie stark das Modell ist, es muss von Daten unterstützt werden. Je mehr Inhalte vorhanden sind, wenn sie nicht konform genutzt werden, werden sie früher oder später Probleme verursachen.⛺️

41,12K

Viele Menschen sprechen über Handelswerkzeuge, und es geht immer nur darum, schneller, günstiger und reibungsloser zu sein. Aber wenn man häufig Multi-Chain-Handel betreibt, insbesondere über Solana, ETH, Base, BSC, wird man verstehen, dass es leicht gesagt ist, aber kaum jemand es wirklich umsetzen kann.

@LABtrade_ möchte im Grunde eine Infrastruktur für den Multi-Chain-Handel schaffen. Man kann weiterhin die gewohnte Handelssoftware nutzen, aber mit schnelleren Geschwindigkeiten, niedrigeren Gebühren und stärkeren Funktionen. Diese Idee ist eigentlich ziemlich clever, da sie die Nutzer nicht zwingt, ihre Gewohnheiten zu ändern, sondern die Basis optimiert. Aus den Daten geht hervor, dass in 20 Tagen ein Handelsvolumen von 150 Millionen US-Dollar und ein Umsatz von 700.000 US-Dollar erzielt wurden, was ziemlich stark ist.

LAB bietet vier Produkte an: Handelsroboter, Anwendungen, Seitenleisten und Browser-Plugins. Diese Werkzeuge können nahtlos auf jeder Handelsplattform betrieben werden. Man muss nicht die Plattform wechseln oder sich an eine neue Benutzeroberfläche gewöhnen, sondern kann direkt in der gewohnten Umgebung schnellere Geschwindigkeiten und niedrigere Gebühren genießen.

Aus geschäftlicher Sicht hat LAB einen sehr praktischen Schmerzpunkt erfasst. Wenn man Chain-Transaktionen durchführt, sind die teuersten und frustrierendsten Aspekte die hohen Gebühren, langsamen Geschwindigkeiten und komplexen Abläufe. Traditionelle DEX haben Gebühren ab 1% und man muss auf Bestätigungen warten, was die Erfahrung wirklich nicht gut macht. LAB hat die Gebühren auf 0,5% gesenkt, ohne Handelsvolumen-Mindestanforderungen, was für Kleinanleger sehr attraktiv ist.

Was die Investoren betrifft, so führt Lemniscap die Runde an, und Animoca, OKX Ventures, Mirana sind allesamt bekannte Institutionen in der Branche. Dieses Investorenportfolio ist ziemlich zuverlässig und zeigt zumindest, dass das Projekt bei den Institutionen eine Due Diligence durchlaufen hat.

Technisch gesehen unterstützt LAB bereits die gängigen Chains wie Solana, Ethereum, Base und BSC. Multi-Chain-Unterstützung ist in der aktuellen, fragmentierten Ökosystemumgebung tatsächlich eine Notwendigkeit, da die Nutzer nicht ständig zwischen verschiedenen Chains ihre Wallets und Werkzeuge wechseln müssen.

Insgesamt ist die Projektidee von LAB ziemlich gut, da sie die echten Bedürfnisse der Nutzer erfasst und die Datenleistung ebenfalls in Ordnung ist. Ob sie sich jedoch in einem intensiven Wettbewerb behaupten kann, muss die Zeit zeigen. Für diejenigen, die teilnehmen möchten, empfehle ich, zunächst mit kleinen Beträgen zu experimentieren, um das Produkt auszuprobieren, bevor sie entscheiden, ob sie tiefer einsteigen wollen.

Link:

34,7K

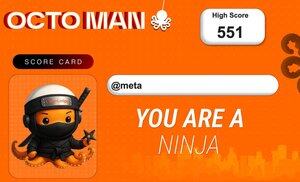

Heute hat @OpenledgerHQ sein eigenes kleines Spiel Octoman veröffentlicht. Ich dachte, ich spiele einfach mal ein bisschen, um die Zeit totzuschlagen, aber als ich erst einmal angefangen habe, konnte ich nicht mehr aufhören. Der Kern des Spiels besteht darin, einen Oktopus durch die Luft schwingen zu lassen und so weit wie möglich zu fliegen, aber diese einfache Mechanik macht es gerade süchtig.

Der Kern des Spiels ist Timing Timing Timing!!!

Die Steuerung des Spiels ist nicht kompliziert, auf dem Handy gibt es nur zwei Richtungstasten und einen Knopf zum Schießen von Spinnweben, am Computer kann man es mit den Tasten WAD erledigen. Aber um das Spiel wirklich gut zu spielen, kommt es darauf an, das Timing des Physik-Engines zu beherrschen. Wann man die Spinnweben loslässt und wann man sie wieder greift, wenn du dieses Timing beherrschst, kannst du in der Luft weit und stabil fliegen.

Interessant ist, dass jedes Mal, wenn du deinen persönlichen Bestwert aktualisierst, das System automatisch eine spezielle Leistungskarte für dich erstellt. Diese Karte ist nicht einfach so gemacht, sondern schaltet je nach Punktzahl verschiedene Seltenheitsgrade von Charakteren frei. Je höher die Punktzahl, desto seltener der Charakter, dieses Design motiviert dich wirklich, deine Rekorde ständig zu verbessern.

Jetzt haben sie eine zweitägige Aktion gestartet, die Regeln sind auch sehr einfach. Du postest deine Leistungskarte auf Twitter, @OpenledgerHQ, und fügst den Hashtag #iloveplayingoctoman hinzu. Man sieht, dass sie wollen, dass die Spieler wirklich teilnehmen.

Aus der Perspektive des Produktdesigns hat Octoman es ziemlich clever gemacht. Das Spiel selbst ist einfach genug, dass jeder es spielen kann, aber um gut zu spielen, braucht man Übung und Geschick. Das Leistungskartensystem gibt den Spielern einen Grund zum Prahlen, und die Verbreitung in sozialen Medien kann neue Nutzer bringen.

Ich habe einfach mal ein bisschen gespielt und 551 Punkte erreicht. Mir wurde direkt ein Ninja-Oktopus gegeben! Das Bild passt perfekt zu meinem Profilbild. Ich habe nicht vor, weiter zu machen, das ist es jetzt. Ich liebe es, ich liebe es!!!

22,67K

Reddit hat offiziell die Nutzung von Inhalten durch das Internet Archive für das Training von KI verboten. Auf den ersten Blick scheint dies eine reguläre Maßnahme zum Schutz der eigenen Daten zu sein, doch dahinter verbirgt sich ein grundlegendes Problem des gesamten KI-Wirtschaftsmodells.

Die aktuelle Situation ist, dass KI-Unternehmen eine riesige Menge an hochwertigen Daten benötigen, um ihre Modelle zu trainieren, während Plattformen und Kreatoren aus diesem Prozess keinerlei Belohnung erhalten. Die mühsam erstellten Inhalte werden von KI-Unternehmen kostenlos zum Training verwendet, und dann verdienen große Unternehmen mit den trainierten Modellen Geld, während die Kreatoren keinen Cent erhalten.

Immer mehr Plattformen beginnen, Barrieren zu errichten; Reddit's Verbot des Internet Archive ist nur der Anfang. Das Problem ist, dass ein einfaches Verbot das grundlegende Problem nicht löst; es schränkt lediglich den Zugang ein, ohne ein angemessenes Lizenz- und Gewinnverteilungssystem zu schaffen.

Was wirklich benötigt wird, ist eine Infrastruktur, die es ermöglicht, dass Nutzungsbedingungen, Eigentumsrechte und Lizenzgebühren bereits auf der Entwurfsebene durchgesetzt werden können.

Camp hat einen neuen Ansatz vorgeschlagen: Anstatt zu verbieten, sollte man die Regeln für die Nutzung von KI-Trainingsdaten neu gestalten. Die Kernlogik ist eigentlich ganz einfach:

1️⃣ Inhalte werden auf der Blockchain registriert, mit Herkunftsnachweis

2️⃣ Kreatoren definieren selbst die Lizenzbedingungen

3️⃣ Wenn KI die Inhalte nutzen möchte, muss sie bezahlen

4️⃣ Lizenzgebühren fließen automatisch an die Kreatoren zurück

Die zugrunde liegende Logik: Anstatt die Nutzung von Inhalten durch KI zu verhindern, sollten die Interessen aller Parteien in Einklang gebracht werden. KI-Unternehmen benötigen Daten, Kreatoren benötigen Einnahmen, Plattformen benötigen ökologischen Wert – jeder bekommt, was er braucht.

Derzeit sind bereits über 1,5 Millionen kreative Werke auf @campnetworkxyz registriert, nicht nur Bilder und Musik, sondern auch Videos, narrative Inhalte und mehr. Es hat sich zu einer dezentralen IP-Originaldatenbank entwickelt. Für KI-Modelle bietet es eine legale, nachhaltige und skalierbare Datenquelle. Für Kreatoren ist es endlich eine Möglichkeit, nicht mehr ausgenutzt zu werden.

35,94K

Die Zusammenarbeit zwischen IQ AI und NEAR basiert auf der Kernlogik, dass KI-Agenten in der Lage sein sollen, selbstständig über verschiedene Blockchains zu agieren, ohne menschliches Eingreifen.

Aus technischer Sicht ist die Blockzeit von 600 ms und die Bestätigungszeit von 1,2 Sekunden bei @NEARProtocol tatsächlich schnell genug. Für KI-Agenten ist eine kürzere Wartezeit besser, denn die Entscheidungsfindung von KI ist ohnehin schneller als die von Menschen. Wenn sie jedoch eine gewisse Zeit warten müssen, um Aktionen auszuführen, wird die gesamte Effizienz relativ beeinträchtigt. Diese Geschwindigkeit ermöglicht jetzt nahezu eine Echtzeitreaktion.

Früher waren Cross-Chain-Operationen für normale Benutzer bereits komplex genug, ganz zu schweigen davon, dass KI-Agenten verschiedene Brückenlogiken verarbeiten müssen. Jetzt, da es direkt in das Entwicklungstoolkit integriert ist, können KI-Agenten selbstständig Cross-Chain-Operationen durchführen, was die Einstiegshürden erheblich senkt.

Strategisch gesehen geht es darum, sich eine Position in der Infrastruktur der KI-Wirtschaft zu sichern. Die Popularität von KI-Agenten steigt, aber es gibt nur wenige Infrastrukturen, die es KI-Agenten ermöglichen, direkt auf die Transaktionsschicht zuzugreifen und an On-Chain-Wirtschaftsaktivitäten teilzunehmen. Durch diese Zusammenarbeit hat NEAR seine Position als L1-Infrastruktur für künstliche Intelligenz und Agenten gefestigt.

Tatsächlich unterscheiden sich die Bedürfnisse von KI-Agenten von den Bedürfnissen der Benutzer selbst. Menschen können komplexe Abläufe tolerieren, können auf Bestätigungszeiten warten und manuell mit verschiedenen Ausnahmesituationen umgehen. Aber KI-Agenten benötigen eine standardisierte, automatisierte und hocheffiziente Ausführungsumgebung.

In Bezug auf Anwendungsfälle ist die Ausführung von Cross-Chain-Transaktionen tatsächlich sehr nützlich. Wenn KI-Agenten gleichzeitig Arbitragemöglichkeiten auf mehreren Blockchains überwachen und nach Entdeckung der Möglichkeiten automatisch Cross-Chain-Arbitrage durchführen können, ist der gesamte Prozess ohne Benutzerbeteiligung viel effektiver. Wenn gleichzeitig mehrere Agenten kooperativ arbeiten können, könnte dies einen noch größeren Wert schaffen.

Für NEAR ist dies eine hervorragende Differenzierung. Während viele L1s um TPS und Ökosysteme konkurrieren, konzentriert sich NEAR durch die Zusammenarbeit mit @IQAICOM auf den vertikalen Bereich der KI-Agenten, was in der frühen Phase eine bedeutende Grundlage für die Zukunft schafft.

NEAR Protocol13. Aug., 21:06

Tokenisierte KI-Agenten sind keine Science-Fiction mehr. Die neue Integration von @IQAICOM mit NEAR ermöglicht autonome Cross-Chain-Aktionen, die schnell, endgültig und sicher sind.

So sieht Chain Abstraction in Aktion aus.

7,29K

Ich habe gerade gesehen, dass @boundless_xyz gestern eine detaillierte Einführung in den ZK Coin veröffentlicht hat. Als jemand, der dieses Projekt schon länger verfolgt, finde ich es ziemlich interessant. Schließlich wollen sie eine universelle Infrastruktur für ZK-Beweise schaffen.

Zunächst einmal das Projekt Boundless selbst. Es geht im Wesentlichen darum, ein allgemeines ZK-Beweisprotokoll zu entwickeln, damit alle Blockchains die ZK-Fähigkeiten nutzen können. Wenn jede Chain jetzt ihr eigenes ZK-Beweissystem aufbauen müsste, wäre das nicht nur kostspielig, sondern auch ineffizient. Boundless bietet durch ein unabhängiges Netzwerk von Beweis-Knoten ZK-Beweisdienste für verschiedene Chains an. Man kann es auch einfach als Outsourcing von Berechnungen verstehen.

Die Erweiterungsmethode ist im Vergleich zu den bestehenden Sharding- oder Layer-2-Lösungen viel einfacher und direkter, indem einfach die Anzahl der Knoten erhöht wird, um die gesamte Netzwerkdurchsatzrate zu steigern.

ZK Coin fungiert als das native Token dieses Systems und ist nicht einfach ein reines Governance-Token. Jede Beweisanforderung erfordert das Staken von ZKC als Sicherheit, und zwar mindestens das Zehnfache der maximalen Gebühr als Sicherheit. Das bedeutet, dass mit zunehmendem Netzwerkverkehr auch die gesperrten ZKC exponentiell wachsen werden, was das zirkulierende Angebot direkt reduziert.

Es gibt auch einen verifizierbaren Arbeitsnachweis-Mechanismus (PoVW), der es den Beweis-Knoten im Wesentlichen ermöglicht, durch die Generierung von ZK-Beweisen ZKC zu minen. Um am Mining teilzunehmen, muss jedoch zunächst eine bestimmte Menge an ZKC gestaked werden. Dies schafft einen positiven Kreislauf: mehr Beweisnachfrage → mehr ZKC werden gestaked → bessere Leistungsanreize → mehr Knoten nehmen teil.

Was die Token-Verteilung betrifft, so gehen 49 % an die ökologische Entwicklung. Wenn man sich jedoch die Verteilungslogik genauer ansieht, werden 31 % des Ökofonds hauptsächlich für drei Bereiche verwendet: Förderung verifizierbarer Anwendungen, Protokollintegration und Entwicklungstools sowie Protokollwartung und Infrastrukturentwicklung. 18 % des strategischen Wachstumsfonds sind speziell für Unternehmensintegration und institutionelle Beweis-Knoten vorgesehen. Diese Verteilung zeigt, dass tatsächlich ein Ökosystem aufgebaut wird.

Das Team und die frühen Mitwirkenden erhalten 23,5 %, wobei 3,5 % speziell für RISC Zero für zukünftige Rekrutierung und Forschung vorgesehen sind. Dieses Detail zeigt, dass die Beziehung zwischen Boundless und RISC Zero sehr eng ist, und RISC Zero hat im Bereich zkVM tatsächlich einiges an Erfahrung.

Der Community-Token-Verkauf und die Airdrops machen nur 6 % aus, was nicht hoch ist. Aber angesichts der Tatsache, dass es sich um ein Infrastrukturprojekt handelt, ist dieser Anteil auch angemessen. Ich frage mich nur, wie viel Yapper später davon abbekommen kann.

Die Verteilung für Investoren beträgt 21,5 %, mit einem Lock-up-Mechanismus, der dem des Teams ähnelt: 1 Jahr Cliff und dann 2 Jahre lineare Freigabe. Dieses Design stellt sicher, dass die Interessen der frühen Investoren und des Teams gebunden sind, sodass es nicht zu einem sofortigen Crash kommt, sobald das Projekt live geht.

Der Inflationsmechanismus beträgt im ersten Jahr 7 % und sinkt dann schrittweise auf 3 %, beginnend im 8. Jahr. Aber entscheidend ist, dass jede Beweisanforderung das Staken von ZKC erfordert, sodass das tatsächliche zirkulierende Angebot mit zunehmendem Netzwerkverkehr schrumpfen wird. Hinzu kommt, dass 50 % des gestakten Betrags direkt verbrannt werden, was ein Gleichgewicht zwischen Inflation und Deflation schafft.

Ich sehe die Highlights von @boundless_xyz in zwei Punkten:

1️⃣ Es ist nicht ein ZK, das nur für eine bestimmte Chain gedacht ist, sondern es wird wirklich versucht, eine universelle ZK-Infrastruktur für alle Chains zu schaffen. Die gewählte Richtung ist tatsächlich eine Grundbedürfnis, die Anwendung von ZK-Technologie im Blockchain-Bereich wird immer breiter und wird zu einer unverzichtbaren Grundlage.

2️⃣ Das Token-Design ist direkt an die Geschäftsbedürfnisse gebunden. Je mehr Beweise, desto mehr ZKC werden gesperrt, die Nachfrage nach Tokens und die Nutzung des Netzwerks sind linear miteinander verbunden.

@TinaLiu333 @RiscZeroCN

46,1K

Gestern habe ich zwei Datensätze verglichen und fand es ziemlich interessant. Ich möchte sie mit euch teilen. Es sind die Daten von Story und Camp. Obwohl ich weiß, dass dieser Vergleich möglicherweise nicht ganz genau ist, da es sich um ein Hauptnetz und ein Testnetz handelt, sind die Daten von Camp wirklich beeindruckend.

1️⃣ Story Protocol Daten

7,6 Millionen Blöcke

43,7 Millionen Transaktionen

4 Millionen Adressen

Täglich 192.000 Transaktionen

2,4 Sekunden Blockzeit

2️⃣ Camp Testnetz Daten

16,2 Millionen Blöcke

84,9 Millionen Transaktionen

6,6 Millionen Adressen

Täglich 842.000 Transaktionen

0,9 Sekunden Blockzeit

Anhand der Daten sieht man, dass @campnetworkxyz in der Testnetzphase in mehreren Dimensionen die Leistung des Hauptnetzes von Story übertroffen hat. Die Anzahl der Blöcke ist mehr als doppelt so hoch wie bei Story, das Transaktionsvolumen ist fast doppelt so hoch, die Anzahl der Adressen hat ebenfalls einen deutlichen Vorteil, und das tägliche Transaktionsvolumen erreicht sogar mehr als das Vierfache von Story.

Story ist erst vor kurzem im Hauptnetz online gegangen, während Camp sich noch in der Testnetzphase befindet. Die Einstellung und das Verhalten der Nutzer sind sicherlich unterschiedlich. Testnetz-Nutzer sind möglicherweise eher bereit, häufig zu interagieren, da sie nicht unter dem Druck von Gas stehen. Aber die Benutzeraktivität und die Netzwerkverarbeitungsfähigkeit, die hinter diesen Zahlen stehen, sind wirklich überzeugend.

Die Architektur von @campnetworkxyz hat im Vergleich dazu tatsächlich einige einzigartige Merkmale. Das Proof of Provenance-Protokoll dient nicht nur der IP-Rechtsklarheit, sondern ähnelt eher dem Aufbau eines Wertesystems für den Austausch zwischen KI und Kreativen. Nutzer können ihre Inhalte als IP registrieren, und wenn die KI diese Daten zum Trainieren oder Generieren von Inhalten verwendet, können die Kreativen eine entsprechende Gewinnverteilung erhalten.

Dieses Modell hat vor dem Hintergrund des aktuellen hohen Verbrauchs von Trainingsdaten durch KI tatsächlich einen einzigartigen Wert. Besonders da hochwertige Trainingsdaten immer seltener werden, könnte Camp mit seinem Mechanismus, der es Nutzern ermöglicht, aktiv Daten beizutragen und dafür belohnt zu werden, zunehmend wichtiger werden.

Aus technischer Sicht ist die Blockzeit von Camp von 0,9 Sekunden tatsächlich deutlich schneller als die von Story mit 2,4 Sekunden. Dieser Leistungsvorteil ist bei der Verarbeitung einer großen Anzahl von IP-Registrierungen und Autorisierungstransaktionen sehr nützlich. Außerdem unterstützen sie gasless IP-Registrierungen, was die Einstiegshürde für normale Nutzer senkt.

Camp befindet sich derzeit noch in der Testnetzphase, aber angesichts dieser Datenleistungen wird es nach dem Start im Hauptnetz sicherlich ein Projekt sein, das man im Auge behalten sollte. Besonders in der Richtung der Kombination von KI und IP freue ich mich auf die Durchbrüche von Camp.

35,88K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten